如果你也在 怎样代写基础编程Fundamental of ProgrammingITCS2530这个学科遇到相关的难题,请随时右上角联系我们的24/7代写客服。基础编程Fundamental of Programming是一个过程,从一个计算问题的原始表述到可执行的计算机程序。编程涉及的活动包括:分析、发展理解、生成算法、验证算法的要求,包括其正确性和资源消耗,以及在目标编程语言中实现(通常称为编码)。

基础编程Fundamental of Programming涉及的任务包括:分析、生成算法、剖析算法的准确性和资源消耗,以及算法的实现(通常用选定的编程语言,通常称为编码)。程序的源代码是用程序员可以理解的一种或多种语言编写的,而不是由中央处理单元直接执行的机器代码。编程的目的是找到一个指令序列,在计算机上自动执行一项任务(可以像操作系统一样复杂),通常是为了解决一个特定的问题。因此,熟练的编程通常需要几个不同学科的专业知识,包括应用领域的知识、专门的算法和形式逻辑。

基础编程Fundamental of Programming代写,免费提交作业要求, 满意后付款,成绩80\%以下全额退款,安全省心无顾虑。专业硕 博写手团队,所有订单可靠准时,保证 100% 原创。 最高质量的基础编程Fundamental of Programming作业代写,服务覆盖北美、欧洲、澳洲等 国家。 在代写价格方面,考虑到同学们的经济条件,在保障代写质量的前提下,我们为客户提供最合理的价格。 由于作业种类很多,同时其中的大部分作业在字数上都没有具体要求,因此基础编程Fundamental of Programming作业代写的价格不固定。通常在专家查看完作业要求之后会给出报价。作业难度和截止日期对价格也有很大的影响。

同学们在留学期间,都对各式各样的作业考试很是头疼,如果你无从下手,不如考虑my-assignmentexpert™!

my-assignmentexpert™提供最专业的一站式服务:Essay代写,Dissertation代写,Assignment代写,Paper代写,Proposal代写,Proposal代写,Literature Review代写,Online Course,Exam代考等等。my-assignmentexpert™专注为留学生提供Essay代写服务,拥有各个专业的博硕教师团队帮您代写,免费修改及辅导,保证成果完成的效率和质量。同时有多家检测平台帐号,包括Turnitin高级账户,检测论文不会留痕,写好后检测修改,放心可靠,经得起任何考验!

想知道您作业确定的价格吗? 免费下单以相关学科的专家能了解具体的要求之后在1-3个小时就提出价格。专家的 报价比上列的价格能便宜好几倍。

计算机代写|基础编程代写Fundamental of Programming代考|Tangled Program Graphs

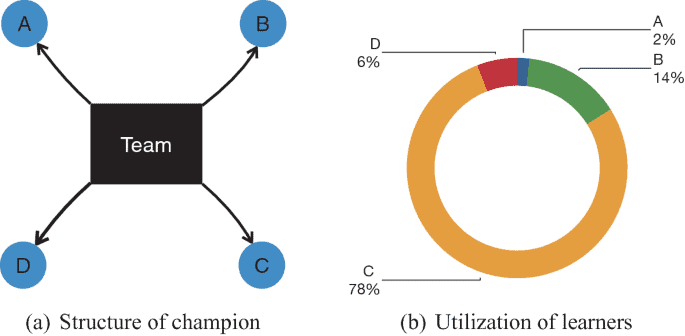

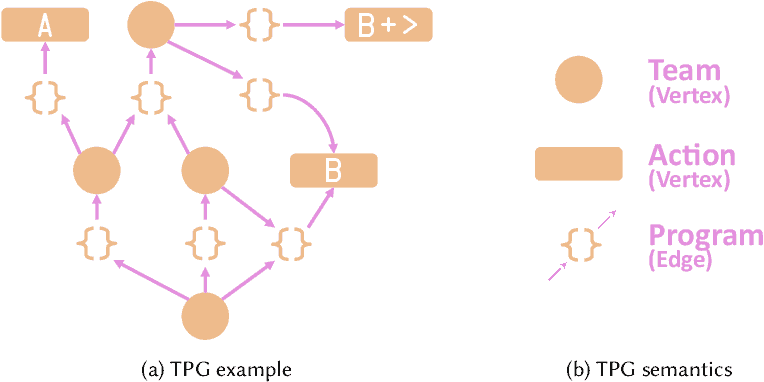

TPG is based on a tuple $\langle T, L\rangle$ defining team and learner populations respectively $[11,12]$. At initialization, each team identifies team compliment through references to a subset of learners from the learner population. Learners are rewarded for iden- tifying the (input) context under which to apply a discrete scalar action. However, as evolution progresses variation operators enable learners to reference individuals from the team population. Such a process provides for the open ended decomposition of a task across the policies as represented by different teams. In the following, we summarize the relationship between members of the Learner (Sect. 1.2.1) and Team (Sect. 1.2.2) populations which ultimately results in the representation of solutions as a ‘graph-of-teams-of-programs’ (Sect. 1.2.3). Section $1.2$ therefore establishes what we take to be ‘canonical TPG’ before we introduce two algorithmic speedups in Sect. 1.3.

Learners

A learner, $L(i)$, is defined in terms of a program, prog, and terminal action, $a$ where $a \in A$ is the set of discrete terminal atomic actions specific to the task environment, or $L(i)=\langle p(i), a(i)\rangle$. A program, $p$, only produces a single output, whether that be the root node of tree structured GP [17] or register $R[0]$ in the case of linear GP [2]. Actions are merely a scalar corresponding to a terminal action (these will later evolve to also encompass pointers to other teams Sect. 1.2.2). The purpose of a program is to define context for the corresponding action. The same program can appear in different learners if it is partnered with a different action. A learner on its own does not define anything useful. Learners only appear in the Learner population, $L$.

计算机代写|基础编程代写Fundamental of Programming代考|Teams

An independent team population, $T$, conducts a search for good combinations of learners using a variable length representation. The following constraints are enforced: (1) each team, $\operatorname{tm}(j)$ must consist of a unique combination of learners, $L(i) \in L ;$ (2) the same learner, $L(i)$, may appear in multiple teams; (3) there cannot be less than two learners in the same team; (4) there must be at least two different actions represented by the complement of learners within the same team.

In order to establish the output of team $\operatorname{tm}(j)$, all programs associated with learners within this team are evaluated on the current input state (provided by the task environment), $\mathbf{s}t$, or $\forall i \in \operatorname{tm}(j): y_i=\operatorname{prog}_i\left(\mathbf{s}_t\right)$. The program with maximum output on $\mathbf{s}_t$ is identified by $i^*=\arg \max _i\left(y_i\right)$. Such a program wins the right to suggest its corresponding atomic action, or $a_t$. Under reinforcement learning tasks, the agent’s action is forwarded to the task, typically resulting in a change to the task environment. Moreover, there is also a scalar reward received at the next time step, $r{t+1}$. Such a reward reflects the relative significance of applying action $a_t$ in state $\mathbf{s}_t$. Such rewards capture underlying properties of the task, such as a robot not colliding with a wall, or the robot’s battery not being exhausted. Thus, the overall interaction between TPG and environment takes the form of a sequence of interactions:

$$

\mathbf{s}0, a_0, r_1, \mathbf{s}_1, a_1, r_2, \ldots, \mathbf{s}_n, a_n, r_T $$ where each TPG-environment interaction is a tuple $\left\langle\mathbf{s}_t, a_t, r{t+1}\right\rangle$ and $r_T$ is the terminal reward received at the task’s end condition. ${ }^1$ Such end conditions might reflect a failure state (point at which a game agent loses a game) or a positive outcome (winning against an opponent, solving a maze) or reflect a computational limit (maximum number of interactions). The goal of TPG is to maximize the average accumulation of rewards as sampled during the interaction defined by the sequence of Eq. 1.1. This means that only after encountering $r_T$ is TPG provided with feedback. This implies that TPG is closest to Policy based Monte Carlo formulations of reinforcement learning [24] , as per the majority of genetic programming applied to reinforcement learning tasks [18].

Variation operators assume that the population of TPG agents are first evaluated, ranked, and the worst Gap teams have been removed (a breeding cycle). Any learners that are not associated with a team, are also deleted. The remaining pool (of teams) represent potential parents, of which Gap are selected and cloned. Only the cloned teams are modified through crossover and mutation. Crossover selects parents pairwise from the pool of surviving teams with uniform probability. The learners common to both appear in both the offspring. Learners unique to each parent are selected to appear in an offspring with probability $P_{c p y}$. Let the result of this process be the set of $G a p$ offspring teams, $L^{\prime}$.

基础编程代写

计算机代写|基础编程代写FUNDAMENTAL OF PROGRAMMING代考|TANGLED PROGRAM GRAPHS

TPG基于元组 $\langle T, L\rangle$ 分别定义团队和学习者群体 $[11,12]$. 在初始化时,每个团队通过参考学习者群体中的学习者子集来识别团队赞美。学习者因识 别出input应用离散标量操作的上下文。然而,随看进化的进展,变异运算符使学习者能够参考团队群体中的个体。这样的过程提供了跨由不同团 队代表的策略的任务的开放式分解。在下文中,我们总结了 Learner 成员之间的关系Sect.1.2.1和团队 Sect.1.2.2最终导致解决方案表示为“程序 团队图”的人口Sect.1.2.3. 部分 $1.2$ 因此,在我们在第 1 节中介绍两个算法加速之前,建立了我们认为是“规范的 TPG”的东西。1.3.

学习者

一个学习者, $L(i)$, 是根据程序、程序和终端操作定义的, $a$ 在哪里 $a \in A$ 是一组特定于任务环境的离散终端原子操作,或者 $L(i)=\langle p(i), a(i)\rangle$.

一个程序, $p$, 只产生一个输出,无论是树结构 GP 的根节点

17

或注册 $R[0]$ 在线性 GP 的情况下

2

动作仅仅是对应于终端动作的标量thesewilllaterevolvetoalsoencompasspointerstootherteamsSect. 1.2.2. 程序的目的是为相应的操作定 义上下文。如果同一个程序与不同的动作配合使用,它可以出现在不同的学习者身上。学习器本身并不能定义任何有用的东西。学习者只出现在 学习者群体中, $L$.

计算机代写|基础编程代写FUNDAMENTAL OF PROGRAMMING代考|TEAMS

一个独立的团队人口, $T$ ,使用可变长度表示搜索学习者的良好组合。强制执行以下约束: 1 各组, $\operatorname{tm}(j)$ 必须由独特的学习者组合组成, $L(i) \in L ; 2$ 同一个学习者, $L(i)$, 可能出现在多个团队中;3同一团队中的学习者不得少于两名; $4 z^2$ 须至少有两个不同的动作由同一个团队中的 学习者的补充来表示。

为了建立团队的输出 $\operatorname{tm}(j)$ ,与该团队中的学习者相关的所有程序都根据当前输入状态进行评估providedbythetaskenvironment, st,或者 $\forall i \in \operatorname{tm}(j): y_i=\operatorname{prog}i\left(\mathbf{s}_t\right)$. 输出最大的程序 $\mathbf{s}_t$ 由 $i^*=\arg \max _i\left(y_i\right)$. 这样的程序赢得了建议其相应原子操作的权利,或者 $a_t$. 在强化学习任务 下,代理的动作被转发给任务,通常会导致任务环境发生变化。此外,还有一个在下一个时间步收到的标量奖励, $r t+1$. 这种奖励反映了应用行 动的相对重要性 $a_t$ 在状态 $\mathbf{s}_t$. 此类奖励捕获任务的潜在属性,例如机器人没有与墙壁碰撞,或者机器人的电池没有耗尽。因此,TPG 与环境之间的 整体交互采用一系列交互的形式: $$ \mathbf{s} 0, a_0, r_1, \mathbf{s}_1, a_1, r_2, \ldots, \mathbf{s}_n, a_n, r_T $$ 其中每个 TPG 环境交互都是一个元组 $\left\langle\mathbf{s}_t, a_t, r t+1\right\rangle$ 和 $r_T$ 是在任务结束条件下收到的最终奖励。 ${ }^1$ 这样的结束条件可能反映了失败状态 pointatwhichagameagentlosesagame 或积极的结果winningagainstanopponent, solvingamaze 或反映计算限制 maximumnumberofinteractions. TPG 的目标是最大化在方程式序列定义的交互过程中采样的奖励的平均侽积。1.1. 这意味着只有在遇到 $r_T$ TPG 是否提供了反馈。这意味着 TPG 最接近强化学习的基于策略的蒙特卡罗公式 24 根据大多数应用于强化学习任务的遗传编程 18 变体算子假设首先对 TPG 智能体的种群进行评估、排序,并且移除最差的 Gap 团队abreedingcycle. 与团队无关的任何学员也将被删除。剩余池 ofteams代表潜在的父母,其中 Gap 被选择和克隆。只有克隆的团队通过交叉和变异进行修改。交叉从幸存团队池中以均匀概率成对选择父母。 两者共有的学习者出现在两个后代中。选择每个父母独有的学习者以概率出现在后代中 $P{c p y}$. 让这个过程的结果是 $G a p$ 后代队, $L^{\prime}$.

计算机代写|基础编程代写Fundamental of Programming代考 请认准UprivateTA™. UprivateTA™为您的留学生涯保驾护航。

微观经济学代写

微观经济学是主流经济学的一个分支,研究个人和企业在做出有关稀缺资源分配的决策时的行为以及这些个人和企业之间的相互作用。my-assignmentexpert™ 为您的留学生涯保驾护航 在数学Mathematics作业代写方面已经树立了自己的口碑, 保证靠谱, 高质且原创的数学Mathematics代写服务。我们的专家在图论代写Graph Theory代写方面经验极为丰富,各种图论代写Graph Theory相关的作业也就用不着 说。

线性代数代写

线性代数是数学的一个分支,涉及线性方程,如:线性图,如:以及它们在向量空间和通过矩阵的表示。线性代数是几乎所有数学领域的核心。

博弈论代写

现代博弈论始于约翰-冯-诺伊曼(John von Neumann)提出的两人零和博弈中的混合策略均衡的观点及其证明。冯-诺依曼的原始证明使用了关于连续映射到紧凑凸集的布劳威尔定点定理,这成为博弈论和数学经济学的标准方法。在他的论文之后,1944年,他与奥斯卡-莫根斯特恩(Oskar Morgenstern)共同撰写了《游戏和经济行为理论》一书,该书考虑了几个参与者的合作游戏。这本书的第二版提供了预期效用的公理理论,使数理统计学家和经济学家能够处理不确定性下的决策。

微积分代写

微积分,最初被称为无穷小微积分或 “无穷小的微积分”,是对连续变化的数学研究,就像几何学是对形状的研究,而代数是对算术运算的概括研究一样。

它有两个主要分支,微分和积分;微分涉及瞬时变化率和曲线的斜率,而积分涉及数量的累积,以及曲线下或曲线之间的面积。这两个分支通过微积分的基本定理相互联系,它们利用了无限序列和无限级数收敛到一个明确定义的极限的基本概念 。

计量经济学代写

什么是计量经济学?

计量经济学是统计学和数学模型的定量应用,使用数据来发展理论或测试经济学中的现有假设,并根据历史数据预测未来趋势。它对现实世界的数据进行统计试验,然后将结果与被测试的理论进行比较和对比。

根据你是对测试现有理论感兴趣,还是对利用现有数据在这些观察的基础上提出新的假设感兴趣,计量经济学可以细分为两大类:理论和应用。那些经常从事这种实践的人通常被称为计量经济学家。

Matlab代写

MATLAB 是一种用于技术计算的高性能语言。它将计算、可视化和编程集成在一个易于使用的环境中,其中问题和解决方案以熟悉的数学符号表示。典型用途包括:数学和计算算法开发建模、仿真和原型制作数据分析、探索和可视化科学和工程图形应用程序开发,包括图形用户界面构建MATLAB 是一个交互式系统,其基本数据元素是一个不需要维度的数组。这使您可以解决许多技术计算问题,尤其是那些具有矩阵和向量公式的问题,而只需用 C 或 Fortran 等标量非交互式语言编写程序所需的时间的一小部分。MATLAB 名称代表矩阵实验室。MATLAB 最初的编写目的是提供对由 LINPACK 和 EISPACK 项目开发的矩阵软件的轻松访问,这两个项目共同代表了矩阵计算软件的最新技术。MATLAB 经过多年的发展,得到了许多用户的投入。在大学环境中,它是数学、工程和科学入门和高级课程的标准教学工具。在工业领域,MATLAB 是高效研究、开发和分析的首选工具。MATLAB 具有一系列称为工具箱的特定于应用程序的解决方案。对于大多数 MATLAB 用户来说非常重要,工具箱允许您学习和应用专业技术。工具箱是 MATLAB 函数(M 文件)的综合集合,可扩展 MATLAB 环境以解决特定类别的问题。可用工具箱的领域包括信号处理、控制系统、神经网络、模糊逻辑、小波、仿真等。