如果你也在 怎样代写深度学习Deep Learning 这个学科遇到相关的难题,请随时右上角联系我们的24/7代写客服。深度学习Deep Learning(也称为深度结构化学习)是更广泛的机器学习方法系列的一部分,它是基于人工神经网络的表征学习。学习可以是监督的、半监督的或无监督的。人工神经网络(ANNs)的灵感来自于生物系统的信息处理和分布式通信节点。人工神经网络与生物大脑有各种不同之处。具体来说,人工神经网络倾向于静态和符号化,而大多数生物体的生物脑是动态(可塑性)和模拟的。

深度学习Deep Learning架构,如深度神经网络、深度信念网络、深度强化学习、递归神经网络、卷积神经网络和变形金刚,已被应用于包括计算机视觉、语音识别、自然语言处理、机器翻译、生物信息学、药物设计、医学图像分析、气候科学、材料检测和棋盘游戏程序等领域,它们产生的结果与人类专家的表现相当,在某些情况下甚至超过了人类专家。

深度学习Deep Learning代写,免费提交作业要求, 满意后付款,成绩80\%以下全额退款,安全省心无顾虑。专业硕 博写手团队,所有订单可靠准时,保证 100% 原创。 最高质量的机器学习Machine Learning作业代写,服务覆盖北美、欧洲、澳洲等 国家。 在代写价格方面,考虑到同学们的经济条件,在保障代写质量的前提下,我们为客户提供最合理的价格。 由于作业种类很多,同时其中的大部分作业在字数上都没有具体要求,因此机器学习Machine Learning作业代写的价格不固定。通常在专家查看完作业要求之后会给出报价。作业难度和截止日期对价格也有很大的影响。

同学们在留学期间,都对各式各样的作业考试很是头疼,如果你无从下手,不如考虑my-assignmentexpert™!

my-assignmentexpert™提供最专业的一站式服务:Essay代写,Dissertation代写,Assignment代写,Paper代写,Proposal代写,Proposal代写,Literature Review代写,Online Course,Exam代考等等。my-assignmentexpert™专注为留学生提供Essay代写服务,拥有各个专业的博硕教师团队帮您代写,免费修改及辅导,保证成果完成的效率和质量。同时有多家检测平台帐号,包括Turnitin高级账户,检测论文不会留痕,写好后检测修改,放心可靠,经得起任何考验!

想知道您作业确定的价格吗? 免费下单以相关学科的专家能了解具体的要求之后在1-3个小时就提出价格。专家的 报价比上列的价格能便宜好几倍。

我们在计算机Quantum computer代写方面已经树立了自己的口碑, 保证靠谱, 高质且原创的计算机Quantum computer代写服务。我们的专家在深度学习Deep Learning代写方面经验极为丰富,各种深度学习Deep Learning相关的作业也就用不着 说。

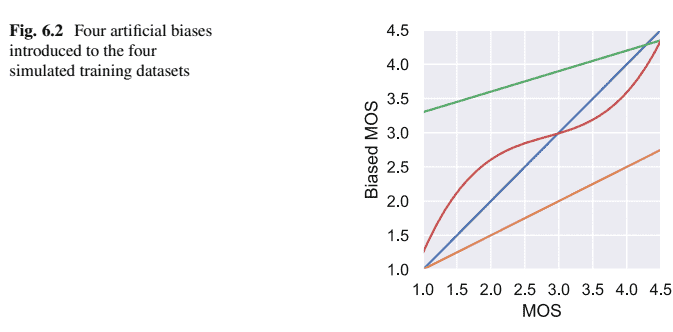

计算机代写|深度学习代写Deep Learning代考|Anchoring Predictions

When the bias-aware loss is applied, the MOS predictions are not anchored to the absolute subjective MOS values and, therefore, can wander off. While the predictions will still rank the samples in the best possible way, there may be a large offset between predictions and subjective values on the validation set. This effect will lead to a higher root-mean-square error while the Pearson’s correlation coefficient (PCC) is usually not affected. To overcome this problem, the predicted MOS values of all samples can be mapped to the subjective MOS after the training.

This mapping can then be applied when making new predictions on validation data. Alternatively, two methods are proposed to anchor the predictions directly during training.

Anchoring with Anchor Dataset

Instead of estimating the bias for all datasets, the predictions are anchored to one specific training dataset. This approach can be particularly useful if there is one dataset of which it is known that the conditions are similar to the conditions that the model should be applied to later. For example, a new dataset is usually created with new conditions and then split into a training and validation set. To increase the training data size and to improve the model accuracy, older datasets are also included in the training set. It is likely that there will be a bias between the new dataset and the older dataset, for example, because the highest quality in the new dataset will be higher than the one in the older datasets. The predictions can be anchored to the new dataset by omitting the bias update for the new dataset only (skipping line 20-23 in Algorithm 1).

Anchoring with Weighted MSE Loss

Another approach to prevent the prediction from wandering off is to add a weighted vanilla MSE loss that will punish predictions that are too far from the original subjective MOS values. The loss is then calculated as follows:

$$

\begin{aligned}

l= & \lambda \frac{1}{N} \sum_{i=1}^N\left(y_i-\widehat{y}i\right)^2 \ & +\frac{1}{N} \sum{i=1}^N\left(y_i-\left(b_{0, i}+b_{1, i} \widehat{y}i+b{2, i} \widehat{y}i^2+b{3, i} \widehat{y}_i^3\right)\right)^2

\end{aligned}

$$

where $\lambda$ is the MSE loss weight. If $\lambda$ is set too high, the bias-aware loss function’s influence will be too low to increase the model accuracy. In this work, the weight was set to a fixed value of $\lambda=0.01$.

计算机代写|深度学习代写Deep Learning代考|Experiments and Results

In this section, the performance of the proposed method is analysed by training the model on different datasets. In the first experiment, a synthetic speech quality dataset is generated for which the biases are known. After that, an experiment with six different speech quality datasets is conducted.

Firstly, a synthetic speech quality dataset is generated to which artificial biases are applied. As source files, the 2-3 s reference speech files from the TSP dataset (Kabal 2002) are used (see also Sect. 3.1.1 for a description of the source files). For the four training datasets overall, 320 speech files and for the validation set, 80 speech files are used. The speech signals were processed with white Gaussian noise to create conditions of different distortion levels. It was found that when the SNR range of the added noise is too wide, it is too easy for the model to predict the quality, and when it is too narrow, the prediction becomes too challenging. Therefore, the speech files were processed with noise at SNR values between 20 and $25 \mathrm{~dB}$, which showed to be a good compromise. To simulate MOS predictions, an S-shaped mapping between the technical impairment factor (i.e. SNR) and MOS, taken from ITU-T Rec. P.107 (2015), is used. The relationship is shown in Fig. 6.1 and maps the SNR values to a MOS between 1 and 4.5. It should be noted that this is an artificial mapping for simulation purposes and does not reflect the real relationship between $S N R$ and MOS.

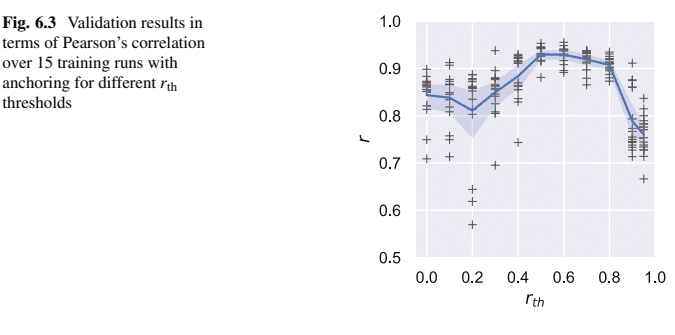

The training data is divided into four different subsets, and a different bias is applied to each of them. These four artificial biases are shown in Fig. 6.2. To better analyse the influence of the bias-aware loss, extreme biases are used in this experiment. There is no bias applied to the first simulated database (blue line). The second and the third simulated databases have linear biases applied, while the fourth database is exposed to a bias modelled with a third-order polynomial function. Each of the training datasets contains 80 files; the validation set also contains 80 files. The synthetic experiments are run by using the CNN-SA-AP model presented in Chap. 3.

深度学习代写

计算机代写|深度学习代写DEEP LEARNING代 芘|ANCHORING PREDICTIONS

当应用偏差感知损失时,MOS 预测不会锚定到绝对主观 MOS 值,因此可能会偏离。虽然预测仍将以最佳方式对样本进行排名,但预测与验证集上 的主观值之间可能存在较大的偏差。这种效应会导致更高的均方根误差,而皮尔逊相关系数 $P C C$ 通常不受影响。为了克服这个问题,可以在训练 后将所有样本的预测 MOS 值映射到主观 MOS。

然后可以在对验证数据进行新预测时应用此映射。或者,提出了两种方法在训练期间直接钿定预测。 使用锚数据集锚定

不是估计所有数据集的偏差,而是将预测针定到一个特定的训练数据集。如果已知一个数据集的条件与模型稍后应应用于的条件相似,则此方法 可能特别有用。例如,通常使用新条件创建新数据集,然后将其拆分为训练集和验证集。为了增加训练数据的大小并提高模型的准确性,较旧的 数据集也包含在训练集中。例如,新数据集和旧数据集之间可能存在偏差,因为新数据集中的最高质量将高于旧数据集中的质量。通过仅省略新 数据集的偏差更新,可以将预测锚定到新数据集skippingline $20-23$ in Algorithm 1 .

使用加权 MSE 损失锚定

另一种防止预测偏离的方法是添加加权香草 MSE 损失,这将惩罚与原始主观 MOS 值相差太远的预测。然后损失计算如下:

$$

l=\lambda \frac{1}{N} \sum_{i=1}^N\left(y_i-\hat{y} i\right)^2 \quad+\frac{1}{N} \sum i=1^N\left(y_i-\left(b_{0, i}+b_{1, i} \hat{y} i+b 2, i \hat{y} i^2+b 3, i \hat{y}_i^3\right)\right)^2

$$

在哪里 $\lambda$ 是 MSE 损失权重。如果 $\lambda$ 设置得太高,偏置感知损失函数的影响将太低而无法提高模型精度。在这项工作中,权重设置为固定值 $\lambda=0.01$

计算机代写|深度学习代写DEEP LEARNING代 考|EXPERIMENTS AND RESULTS

在本节中,通过在不同数据集上训练模型来分析所提出方法的性能。在第一个实验中,生成了一个已知偏差的合成语音质量数据集。之后,进行 了六个不同语音质量数据集的实验。

首先,生成一个合成语音质量数据集,并对其应用人工偏差。作为源文件,来自 TSP数据集的 $2-3 \mathrm{~s}$ 参考语音文件Kabal2002被使用 seealsoSect.3.1.1 foradescriptionofthesourcefiles. 对于总共四个训练数据集,使用了 320 个语音文件,对于验证集,使用了 80 个语音文 件。语音信号经过高斯白噪声处理,以创造不同失真水平的条件。结果发现,当添加噪声的 SNR 范围太宽时,模型太容易预测质量,而当太窄 时,预测变得太具有挑战性。因此,语音文件在 SNR 值介于 20 和 $25 \mathrm{~dB}$, 这被证明是一个很好的妥协。为了模拟 MOS预测,技术损伤因子之间的 S 形映射 i.e.SNR和 MOS,取自 ITU-T Rec. 第107页 2015,用来。该关系如图 6.1 所示,并将 SNR 值映射到 1 到 4.5 之间的 MOS。需要注意的是, 这是出于模拟目的的人工映射,并不反映两者之间的真实关系 $S N R$ 和MOS。

训练数据被分成四个不同的子集,并且对每个子集应用不同的偏差。这四种人为偏差如图 6.2 所示。为了更好地分析偏差感知损失的影响,本实验 使用了极端偏差。没有偏差应用于第一个模拟数据库blueline. 第二个和第三个模拟数据库应用了线性偏差,而第四个数据库暴露于用三阶多项式 函数建模的偏差。每个训练数据集包含 80 个文件;验证集还包含 80 个文件。综合实验是通过使用第 1 章中介绍的 CNN-SA-AP 模型运行的。3.

计算机代写|深度学习代写Deep Learning代考 请认准UprivateTA™. UprivateTA™为您的留学生涯保驾护航。

微观经济学代写

微观经济学是主流经济学的一个分支,研究个人和企业在做出有关稀缺资源分配的决策时的行为以及这些个人和企业之间的相互作用。my-assignmentexpert™ 为您的留学生涯保驾护航 在数学Mathematics作业代写方面已经树立了自己的口碑, 保证靠谱, 高质且原创的数学Mathematics代写服务。我们的专家在图论代写Graph Theory代写方面经验极为丰富,各种图论代写Graph Theory相关的作业也就用不着 说。

线性代数代写

线性代数是数学的一个分支,涉及线性方程,如:线性图,如:以及它们在向量空间和通过矩阵的表示。线性代数是几乎所有数学领域的核心。

博弈论代写

现代博弈论始于约翰-冯-诺伊曼(John von Neumann)提出的两人零和博弈中的混合策略均衡的观点及其证明。冯-诺依曼的原始证明使用了关于连续映射到紧凑凸集的布劳威尔定点定理,这成为博弈论和数学经济学的标准方法。在他的论文之后,1944年,他与奥斯卡-莫根斯特恩(Oskar Morgenstern)共同撰写了《游戏和经济行为理论》一书,该书考虑了几个参与者的合作游戏。这本书的第二版提供了预期效用的公理理论,使数理统计学家和经济学家能够处理不确定性下的决策。

微积分代写

微积分,最初被称为无穷小微积分或 “无穷小的微积分”,是对连续变化的数学研究,就像几何学是对形状的研究,而代数是对算术运算的概括研究一样。

它有两个主要分支,微分和积分;微分涉及瞬时变化率和曲线的斜率,而积分涉及数量的累积,以及曲线下或曲线之间的面积。这两个分支通过微积分的基本定理相互联系,它们利用了无限序列和无限级数收敛到一个明确定义的极限的基本概念 。

计量经济学代写

什么是计量经济学?

计量经济学是统计学和数学模型的定量应用,使用数据来发展理论或测试经济学中的现有假设,并根据历史数据预测未来趋势。它对现实世界的数据进行统计试验,然后将结果与被测试的理论进行比较和对比。

根据你是对测试现有理论感兴趣,还是对利用现有数据在这些观察的基础上提出新的假设感兴趣,计量经济学可以细分为两大类:理论和应用。那些经常从事这种实践的人通常被称为计量经济学家。

Matlab代写

MATLAB 是一种用于技术计算的高性能语言。它将计算、可视化和编程集成在一个易于使用的环境中,其中问题和解决方案以熟悉的数学符号表示。典型用途包括:数学和计算算法开发建模、仿真和原型制作数据分析、探索和可视化科学和工程图形应用程序开发,包括图形用户界面构建MATLAB 是一个交互式系统,其基本数据元素是一个不需要维度的数组。这使您可以解决许多技术计算问题,尤其是那些具有矩阵和向量公式的问题,而只需用 C 或 Fortran 等标量非交互式语言编写程序所需的时间的一小部分。MATLAB 名称代表矩阵实验室。MATLAB 最初的编写目的是提供对由 LINPACK 和 EISPACK 项目开发的矩阵软件的轻松访问,这两个项目共同代表了矩阵计算软件的最新技术。MATLAB 经过多年的发展,得到了许多用户的投入。在大学环境中,它是数学、工程和科学入门和高级课程的标准教学工具。在工业领域,MATLAB 是高效研究、开发和分析的首选工具。MATLAB 具有一系列称为工具箱的特定于应用程序的解决方案。对于大多数 MATLAB 用户来说非常重要,工具箱允许您学习和应用专业技术。工具箱是 MATLAB 函数(M 文件)的综合集合,可扩展 MATLAB 环境以解决特定类别的问题。可用工具箱的领域包括信号处理、控制系统、神经网络、模糊逻辑、小波、仿真等。