如果你也在 怎样代写优化方法Optimization这个学科遇到相关的难题,请随时右上角联系我们的24/7代写客服。优化方法Optimization又称优化)或数学编程是指从一组可用的备选方案中选择一个最佳元素。从计算机科学和工程到运筹学和经济学的所有定量学科中都会出现各种优化问题,几个世纪以来,数学界一直在关注解决方法的发展。

优化方法Optimization在最简单的情况下,优化问题包括通过系统地从一个允许的集合中选择输入值并计算出函数的值来最大化或最小化一个实际函数。将优化理论和技术推广到其他形式,构成了应用数学的一个大领域。更一般地说,优化包括在给定的域(或输入)中寻找一些目标函数的 “最佳可用 “值,包括各种不同类型的目标函数和不同类型的域。非凸全局优化的一般问题是NP-完备的,可接受的深层局部最小值是用遗传算法(GA)、粒子群优化(PSO)和模拟退火(SA)等启发式方法来寻找的 。

my-assignmentexpert™ 优化方法Optimization作业代写,免费提交作业要求, 满意后付款,成绩80\%以下全额退款,安全省心无顾虑。专业硕 博写手团队,所有订单可靠准时,保证 100% 原创。my-assignmentexpert™, 最高质量的优化方法Optimization作业代写,服务覆盖北美、欧洲、澳洲等 国家。 在代写价格方面,考虑到同学们的经济条件,在保障代写质量的前提下,我们为客户提供最合理的价格。 由于统计Statistics作业种类很多,同时其中的大部分作业在字数上都没有具体要求,因此优化方法Optimization作业代写的价格不固定。通常在经济学专家查看完作业要求之后会给出报价。作业难度和截止日期对价格也有很大的影响。

想知道您作业确定的价格吗? 免费下单以相关学科的专家能了解具体的要求之后在1-3个小时就提出价格。专家的 报价比上列的价格能便宜好几倍。

my-assignmentexpert™ 为您的留学生涯保驾护航 在数学Mathematics作业代写方面已经树立了自己的口碑, 保证靠谱, 高质且原创的优化方法Optimization代写服务。我们的专家在数学Mathematics代写方面经验极为丰富,各种优化方法Optimization相关的作业也就用不着 说。

我们提供的优化方法Optimization及其相关学科的代写,服务范围广, 其中包括但不限于:

调和函数 harmonic function

椭圆方程 elliptic equation

抛物方程 Parabolic equation

双曲方程 Hyperbolic equation

非线性方法 nonlinear method

变分法 Calculus of Variations

几何分析 geometric analysis

偏微分方程数值解 Numerical solution of partial differential equations

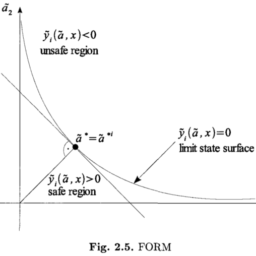

数学代写|优化方法作业代写Optimization代考|Approximation of the Loss Function

Suppose here that $\gamma=\gamma(y)$ is a continuously differentiable, convex loss function on $\mathbb{R}^{m_{y}}$. Let then denote

$$

\bar{y}(x):=E y(a(\omega), x)=\left(E y_{1}(a(\omega), x), \ldots, E y_{m_{y}}(a(\omega), x)\right)^{T}

$$

the expectation of the vector $y=y(a(\omega), x)$ of state functions $y_{i}=$ $y_{i}(a(\omega), x), i=1, \ldots, m_{y} .$

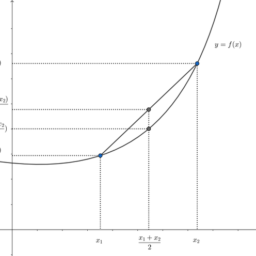

For an arbitrary continuously differentiable, convex loss function $\gamma$ we have

$$

\gamma(y(a(\omega), x)) \geq \gamma(\bar{y}(x))+\nabla \gamma(\bar{y}(x))^{T}(y(a(\omega), x)-\bar{y}(x))

$$

Thus, taking expectations in (2.25a), we find Jensen’s inequality

$$

\Gamma(x)=E \gamma(y(a(\omega), x)) \geq \gamma(\bar{y}(x))

$$

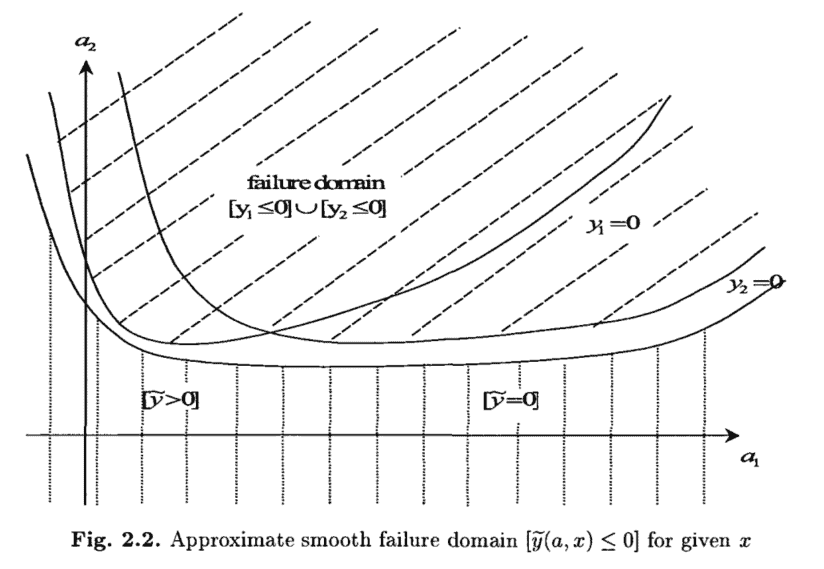

数学代写|优化方法作业代写Optimization代考|Regression Techniques, RSM

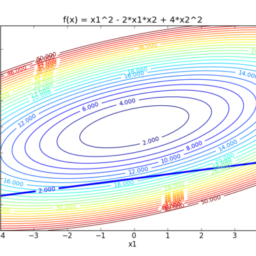

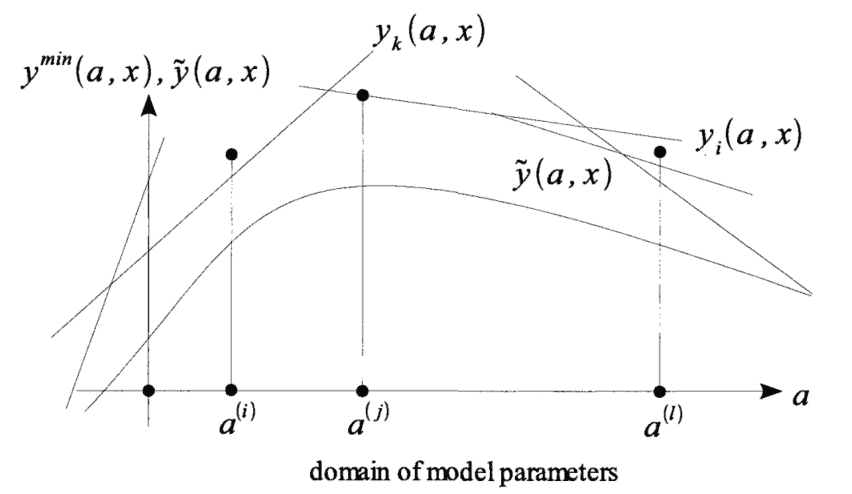

Approximation of state functions. The numerical solution is simplified considerably if one can work with one single state function $y=y(a, x)$. Formally, this is possible by defining the function $$

y^{\min }(a, x):=\min {1 \leq i \leq m{y}} y_{i}(a, x) .

$$

Indeed, according to $(2.2 \mathrm{~b}, \mathrm{c})$ the failure of the structure, the system can be represented by the condition

$$

y^{\min }(a, x) \leq 0 .

$$

Thus, the weakness or failure of the technical or economic device can be evaluated numerically by the function

$$

\Gamma(x):=E \gamma\left(y^{\min }(a(\omega), x)\right)

$$

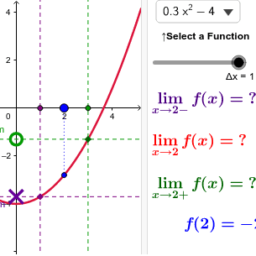

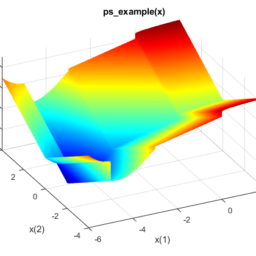

with a nonincreasing loss function $\gamma: \mathbb{R} \rightarrow \mathbb{R}{+}$, see Fig. 2.1. However, the “min”-operator in (2.30a) yields a nonsmooth function $y^{\min }=y^{\min }(a, x)$ in general, and the computation of the mean and covariance function $$ \begin{aligned} \overline{y^{\min }}(x) &:=E y^{\min }(a(\omega), x) \ Q{y^{\min }}(x) &:=\operatorname{cov}\left(y^{\min }(a(\cdot), x)\right)

\end{aligned}

$$

by means of Taylor expansion with respect to the model parameter vector $a$ at $\bar{a}=E a(\omega)$ is not possible directly, cf. Section 2.3.3.

Using regression techniques, Response Surface Methods (RSM), etc., for given vector $x$, the function $a \rightarrow y^{\min }(a, x)$ can be approximated $[13,22$, $49,56,123]$ by functions $\tilde{y}=\tilde{y}(a, x)$ being sufficiently smooth with respect to the parameter vector $a$.

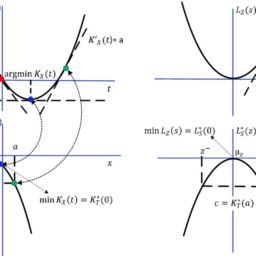

数学代写|优化方法作业代写OPTIMIZATION代考|Taylor Expansion Methods

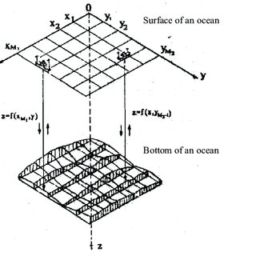

As can be seen above, cf. $(2.21 \mathrm{a}, \mathrm{b})$, in the objective and/or in the constraints of substitute problems for optimization problems with random data mean value functions of the type

$$

\Gamma(x):=\operatorname{Eg}(a(\omega), x)

$$

occur. Here, $g=g(a, x)$ is a real valued function on a subset of $\mathbb{R}^{\nu} \times \mathbb{R}^{r}$, and $a=a(\omega)$ is a $\nu$-random vector.

优化方法代写

数学代写|优化方法作业代写OPTIMIZATION代考|APPROXIMATION OF THE LOSS FUNCTION

假设这里C=C(是)是一个连续可微的凸损失函数R米是. 让然后表示

是¯(X):=和是(一种(ω),X)=(和是1(一种(ω),X),…,和是米是(一种(ω),X))吨

向量的期望是=是(一种(ω),X)状态函数是一世= 是一世(一种(ω),X),一世=1,…,米是.

对于任意连续可微的凸损失函数C我们有

$\gamma$ we have

$$

\gamma(y(a(\omega), x)) \geq \gamma(\bar{y}(x))+\nabla \gamma(\bar{y}(x))^{T}(y(a(\omega), x)-\bar{y}(x))

$$

Thus, taking expectations in (2.25a), we find Jensen’s inequality

$$

\Gamma(x)=E \gamma(y(a(\omega), x)) \geq \gamma(\bar{y}(x))

$$

数学代写|优化方法作业代写OPTIMIZATION代考|REGRESSION TECHNIQUES, RSM

状态函数的近似。如果可以使用一个单一状态函数,则数值解会大大简化是=是(一种,X). 形式上,这可以通过定义函数 $y=y(a, x)$. Formally, this is possible by defining the function $$

y^{\min }(a, x):=\min {1 \leq i \leq m{y}} y_{i}(a, x) .

$$

Indeed, according to $(2.2 \mathrm{~b}, \mathrm{c})$ the failure of the structure, the system can be represented by the condition

$$

y^{\min }(a, x) \leq 0 .

$$

Thus, the weakness or failure of the technical or economic device can be evaluated numerically by the function

$$

\Gamma(x):=E \gamma\left(y^{\min }(a(\omega), x)\right)

$$

with a nonincreasing loss function $\gamma: \mathbb{R} \rightarrow \mathbb{R}{+}$, see Fig. 2.1. However, the “min”-operator in (2.30a) yields a nonsmooth function $y^{\min }=y^{\min }(a, x)$ in general, and the computation of the mean and covariance function $$ \begin{aligned} \overline{y^{\min }}(x) &:=E y^{\min }(a(\omega), x) \ Q{y^{\min }}(x) &:=\operatorname{cov}\left(y^{\min }(a(\cdot), x)\right)

\end{aligned}

$$

通过关于模型参数向量的泰勒展开一种在一种¯=和一种(ω)不可能直接,cf。第 2.3.3 节。

使用回归技术,响应面方法R小号米等,对于给定的向量X, 功能一种→是分钟(一种,X)可以近似[13,22, 49,56,123]按功能是~=是~(一种,X)关于参数向量足够平滑一种.

数学代写|优化方法作业代写OPTIMIZATION代考|TAYLOR EXPANSION METHODS

从上面可以看出,cf。(2.21一种,b), 在目标和/或替代问题的约束中,用于具有随机数据均值函数类型的优化问题

Γ(X):=例如(一种(ω),X)

发生。这里,G=G(一种,X)是一个子集上的实值函数Rν×Rr, 和一种=一种(ω)是一个ν-随机向量。

数学代写|优化方法作业代写Optimization代考 请认准UprivateTA™. UprivateTA™为您的留学生涯保驾护航。