如果你也在 怎样代写多元统计分析Multivariate Statistical Analysis这个学科遇到相关的难题,请随时右上角联系我们的24/7代写客服。多元统计分析Multivariate Statistical Analysis在此重定向。在数学上的用法,见多变量微积分。多变量统计是统计学的一个分支,包括同时观察和分析一个以上的结果变量。多变量统计涉及到理解每一种不同形式的多变量分析的不同目的和背景,以及它们之间的关系。多变量统计在特定问题上的实际应用可能涉及几种类型的单变量和多变量分析,以了解变量之间的关系以及它们与所研究问题的相关性。

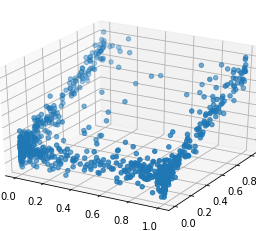

多元统计分析Multivariate Statistical Analysis通常情况下,希望使用多变量分析的研究会因为问题的维度而停滞。这些问题通常通过使用代理模型来缓解,代理模型是基于物理学的代码的高度精确的近似。由于代用模型采取方程的形式,它们可以被快速评估。这成为大规模MVA研究的一个有利因素:在基于物理学的代码中,整个设计空间的蒙特卡洛模拟是困难的,而在评估代用模型时,它变得微不足道,代用模型通常采取响应面方程的形式。

my-assignmentexpert™ 多元统计分析Multivariate Statistical Analysis作业代写,免费提交作业要求, 满意后付款,成绩80\%以下全额退款,安全省心无顾虑。专业硕 博写手团队,所有订单可靠准时,保证 100% 原创。my-assignmentexpert™, 最高质量的多元统计分析Multivariate Statistical Analysis作业代写,服务覆盖北美、欧洲、澳洲等 国家。 在代写价格方面,考虑到同学们的经济条件,在保障代写质量的前提下,我们为客户提供最合理的价格。 由于统计Statistics作业种类很多,同时其中的大部分作业在字数上都没有具体要求,因此多元统计分析Multivariate Statistical Analysis作业代写的价格不固定。通常在经济学专家查看完作业要求之后会给出报价。作业难度和截止日期对价格也有很大的影响。

想知道您作业确定的价格吗? 免费下单以相关学科的专家能了解具体的要求之后在1-3个小时就提出价格。专家的 报价比上列的价格能便宜好几倍。

my-assignmentexpert™ 为您的留学生涯保驾护航 在数学Mathematics作业代写方面已经树立了自己的口碑, 保证靠谱, 高质且原创的多元统计分析Multivariate Statistical Analysis代写服务。我们的专家在数学Mathematics代写方面经验极为丰富,各种多元统计分析Multivariate Statistical Analysis相关的作业也就用不着 说。

我们提供的多元统计分析Multivariate Statistical Analysis及其相关学科的代写,服务范围广, 其中包括但不限于:

非线性方法 nonlinear method functional analysis

变分法 Calculus of Variations

统计代写|多元统计分析作业代写Multivariate Statistical Analysis代考|Elementary Properties of the Multinormal

Let us first summarize some properties which were already derived in the previous chapter.

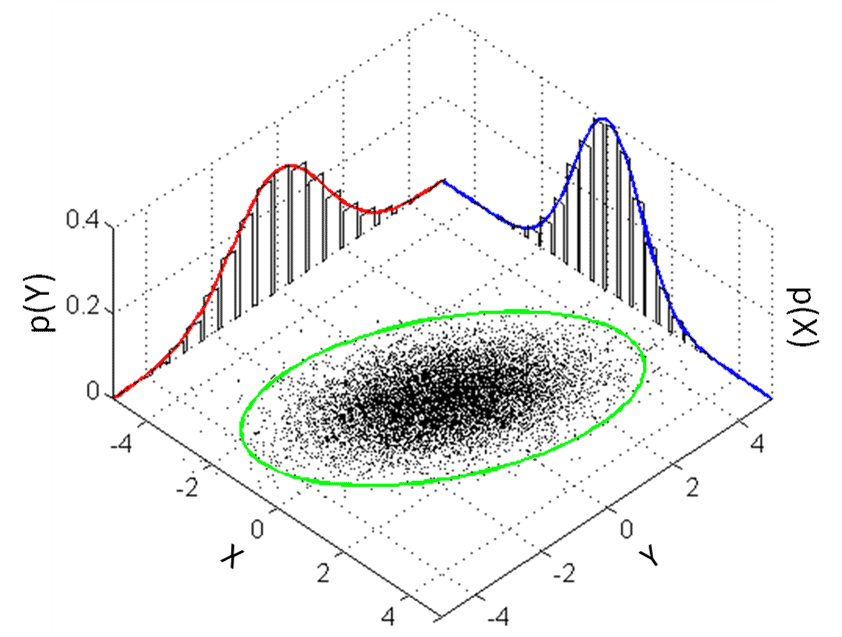

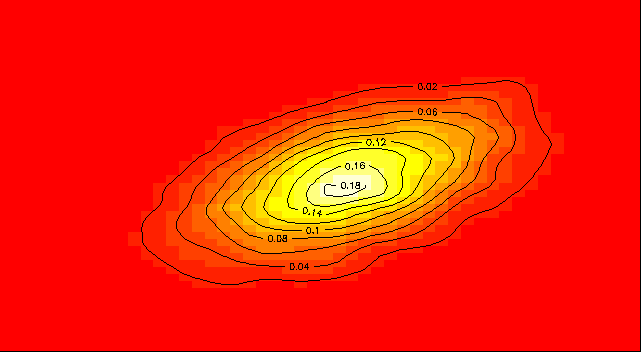

The pdf of $X \sim N_{p}(\mu, \Sigma)$ is

$$

f(x)=|2 \pi \Sigma|^{-1 / 2} \exp \left{-\frac{1}{2}(x-\mu)^{\top} \Sigma^{-1}(x-\mu)\right} .

$$

The expectation is $E(X)=\mu$, the covariance can be calculated as $\operatorname{Var}(X)=$ $E(X-\mu)(X-\mu)^{\top}=\Sigma$.

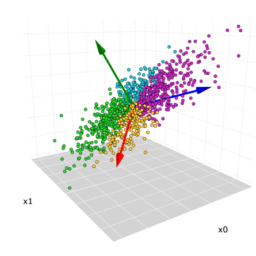

Linear transformations turn normal random variables into normal random variables. If $X \sim N_{p}(\mu, \Sigma)$ and $\mathcal{A}(p \times p), c \in \mathbb{R}^{p}$, then $Y=\mathcal{A} X+c$ is $p$-variate Normal, i.e.,

$$

Y \sim N_{p}\left(\mathcal{A} \mu+c, \mathcal{A} \Sigma \mathcal{A}^{\top}\right) .

$$

If $X \sim N_{p}(\mu, \Sigma)$, then the Mahalanobis transformation is

$$

Y=\Sigma^{-1 / 2}(X-\mu) \sim N_{p}\left(0, \mathcal{I}{p}\right) $$ and it holds that $$ Y^{\top} Y=(X-\mu)^{\top} \Sigma^{-1}(X-\mu) \sim \chi{p}^{2} .

$$

Often it is interesting to partition $X$ into sub-vectors $X_{1}$ and $X_{2}$. The following theorem tells us how to correct $X_{2}$ to obtain a vector which is independent of $X_{1}$.

THEOREM 5.1 Let $X=\left(\begin{array}{l}X_{1} \ X_{2}\end{array}\right) \sim N_{p}(\mu, \Sigma), X_{1} \in \mathbb{R}^{r}, X_{2} \in \mathbb{R}^{p-r}$. Define $X_{2.1}=X_{2}-$ $\Sigma_{21} \Sigma_{11}^{-1} X_{1}$ from the partitioned covariance matrix

$$

\Sigma=\left(\begin{array}{cc}

\Sigma_{11} & \Sigma_{12} \

\Sigma_{21} & \Sigma_{22}

\end{array}\right) .

$$

统计代写|多元统计分析作业代写Multivariate Statistical Analysis代考|The Wishart Distribution

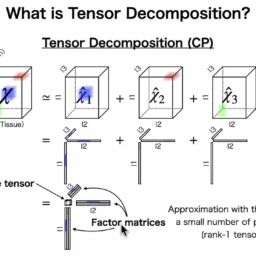

The Wishart distribution (named after its discoverer) plays a prominent role in the analysis of estimated covariance matrices. If the mean of $X \sim N_{p}(\mu, \Sigma)$ is known to be $\mu=0$, then for a data matrix $\mathcal{X}(n \times p)$ the estimated covariance matrix is proportional to $\mathcal{X}^{\top} \mathcal{X}$. This is the point where the Wishart distribution comes in, because $\mathcal{M}(p \times p)=\mathcal{X}^{\top} \mathcal{X}=\sum_{i=1}^{n} x_{i} x_{i}^{\top}$ has a Wishart distribution $W_{p}(\Sigma, n)$.

EXAMPLE 5.4 Set $p=1$, then for $X \sim N_{1}\left(0, \sigma^{2}\right)$ the data matrix of the observations

$$

\mathcal{X}=\left(x_{1}, \ldots, x_{n}\right)^{\top} \quad \text { with } \quad \mathcal{M}=\mathcal{X}^{\top} \mathcal{X}=\sum_{i=1}^{n} x_{i} x_{i}

$$

leads to the Wishart distribution $W_{1}\left(\sigma^{2}, n\right)=\sigma^{2} \chi_{n}^{2}$. The one-dimensional Wishart distribution is thus in fact a $\chi^{2}$ distribution.

When we talk about the distribution of a matrix, we mean of course the joint distribution of all its elements. More exactly: since $\mathcal{M}=\mathcal{X}^{\top} \mathcal{X}$ is symmetric we only need to consider the elements of the lower triangular matrix

$$

\mathcal{M}=\left(\begin{array}{cccc}

m_{11} & & & \

m_{21} & m_{22} & & \

\vdots & \vdots & \ddots & \

m_{p 1} & m_{p 2} & \ldots & m_{p p}

\end{array}\right) .

$$

Hence the Wishart distribution is defined by the distribution of the vector

$$

\left(m_{11}, \ldots, m_{p 1}, m_{22}, \ldots, m_{p 2}, \ldots, m_{p p}\right)^{\top} .

$$

Linear transformations of the data matrix $\mathcal{X}$ also lead to Wishart matrices.

统计代写|多元统计分析作业代写MULTIVARIATE STATISTICAL ANALYSIS代考|Hotelling’s T2-Distribution

Suppose that $Y \in \mathbb{R}^{p}$ is a standard normal random vector, i.e., $Y \sim N_{p}(0, \mathcal{I})$, independent of the random matrix $\mathcal{M} \sim W_{p}(\mathcal{I}, n)$. What is the distribution of $Y^{\top} \mathcal{M}^{-1} Y$ ? The answer is provided by the Hotelling $T^{2}$-distribution: $n Y^{\top} \mathcal{M}^{-1} Y$ is Hotelling $T^{2}(p, n)$ distributed.

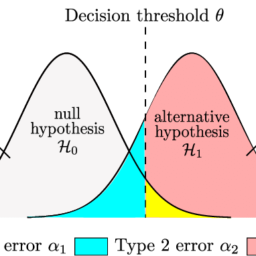

The Hotelling $T^{2}$-distribution is a generalization of the Student $t$-distribution. The general multinormal distribution $N(\mu, \Sigma)$ is considered in Theorem 5.8. The Hotelling $T^{2}$ distribution will play a central role in hypothesis testing in Chapter 7 .

THEOREM 5.8 If $X \sim N_{p}(\mu, \Sigma)$ is independent of $\mathcal{M} \sim W_{p}(\Sigma, n)$, then

$$

n(X-\mu)^{\top} \mathcal{M}^{-1}(X-\mu) \sim T^{2}(p, n) .

$$

COROLLARY $5.3$ If $\bar{x}$ is the mean of a sample drawn from a normal population $N_{p}(\mu, \Sigma)$ and $\mathcal{S}$ is the sample covariance matrix, then

$$

(n-1)(\bar{x}-\mu)^{\top} \mathcal{S}^{-1}(\bar{x}-\mu)=n(\bar{x}-\mu)^{\top} \mathcal{S}{u}^{-1}(\bar{x}-\mu) \sim T^{2}(p, n-1) . $$ Recall that $\mathcal{S}{u}=\frac{n}{n-1} \mathcal{S}$ is an unbiased estimator of the covariance matrix. A connection between the Hotelling $T^{2}$-and the $F$-distribution is given by the next theorem.

多元统计分析代写

统计代写|多元统计分析作业代写MULTIVARIATE STATISTICAL ANALYSIS代考|ELEMENTARY PROPERTIES OF THE MULTINORMAL

让我们首先总结一些在前一章已经推导出来的性质。

的pdfX∼ñp(μ,Σ)是

f(x)=|2 \pi \Sigma|^{-1 / 2} \exp \left{-\frac{1}{2}(x-\mu)^{\top} \Sigma^{-1 }(x-\mu)\right} 。f(x)=|2 \pi \Sigma|^{-1 / 2} \exp \left{-\frac{1}{2}(x-\mu)^{\top} \Sigma^{-1 }(x-\mu)\right} 。

期望是和(X)=μ,协方差可以计算为曾是(X)= 和(X−μ)(X−μ)⊤=Σ.

线性变换将正态随机变量转换为正态随机变量。如果X∼ñp(μ,Σ)和一种(p×p),C∈Rp, 然后是=一种X+C是p- 变正态,即,

是∼ñp(一种μ+C,一种Σ一种⊤).

如果X∼ñp(μ,Σ),则马氏变换为

$$

Y=\Sigma^{-1 / 2}X−μ\sim N_{p}\left(0, \mathcal{I} {p}\right)一种nd一世吨H这lds吨H一种吨Y^{\top} Y=X−μ^{\top} \Sigma^{-1}X−μ\sim \chi {p}^{2} 。

$$

通常分区很有趣X成子向量X1和X2. 下面的定理告诉我们如何纠正X2获得一个独立于的向量X1.

定理 5.1 让X=(X1 X2)∼ñp(μ,Σ),X1∈Rr,X2∈Rp−r. 定义X2.1=X2− Σ21Σ11−1X1从分区协方差矩阵

Σ=(Σ11Σ12 Σ21Σ22).

统计代写|多元统计分析作业代写MULTIVARIATE STATISTICAL ANALYSIS代考|THE WISHART DISTRIBUTION

Wishart 分布n一种米和d一种F吨和r一世吨sd一世sC这在和r和r在估计协方差矩阵的分析中起着重要作用。如果平均值X∼ñp(μ,Σ)已知是μ=0,那么对于一个数据矩阵X(n×p)估计的协方差矩阵与X⊤X. 这就是 Wishart 分布的用武之地,因为米(p×p)=X⊤X=∑一世=1nX一世X一世⊤有一个 Wishart 分布在p(Σ,n).

例 5.4 设置p=1,那么对于X∼ñ1(0,σ2)观察的数据矩阵

X=(X1,…,Xn)⊤ 和 米=X⊤X=∑一世=1nX一世X一世

导致 Wishart 分布在1(σ2,n)=σ2χn2. 因此,一维 Wishart 分布实际上是χ2分配。

当我们谈论矩阵的分布时,我们当然指的是其所有元素的联合分布。更准确地说:因为米=X⊤X是对称的,我们只需要考虑下三角矩阵的元素

米=(米11 米21米22 ⋮⋮⋱ 米p1米p2…米pp).

因此,Wishart 分布由向量的分布定义

(米11,…,米p1,米22,…,米p2,…,米pp)⊤.

数据矩阵的线性变换X也导致 Wishart 矩阵。

统计代写|多元统计分析作业代写MULTIVARIATE STATISTICAL ANALYSIS代考|HOTELLING’S T2-DISTRIBUTION

假设是∈Rp是标准正态随机向量,即是∼ñp(0,一世),独立于随机矩阵米∼在p(一世,n). 什么是分布是⊤米−1是? 答案由Hotelling提供吨2-分配:n是⊤米−1是是霍特林吨2(p,n)分散式。

霍特林吨2-分布是学生的概括吨-分配。一般多正态分布ñ(μ,Σ)在定理 5.8 中考虑。霍特林吨2分布将在第 7 章的假设检验中发挥核心作用。

定理 5.8 如果X∼ñp(μ,Σ)独立于米∼在p(Σ,n), 然后

n(X−μ)⊤米−1(X−μ)∼吨2(p,n).

推论5.3如果X¯是从正常人群中抽取的样本的平均值ñp(μ,Σ)和小号是样本协方差矩阵,则

$$

n(X-\mu)^{\top} \mathcal{M}^{-1}(X-\mu) \sim T^{2}(p, n) .

$$

COROLLARY $5.3$ If $\bar{x}$ is the mean of a sample drawn from a normal population $N_{p}(\mu, \Sigma)$ and $\mathcal{S}$ is the sample covariance matrix, then

$$

(n-1)(\bar{x}-\mu)^{\top} \mathcal{S}^{-1}(\bar{x}-\mu)=n(\bar{x}-\mu)^{\top} \mathcal{S}{u}^{-1}(\bar{x}-\mu) \sim T^{2}(p, n-1) . $$ Recall that $\mathcal{S}{u}=\frac{n}{n-1} \分布由下一个定理给出。

统计代写|多元统计分析作业代写Multivariate Statistical Analysis代考 请认准UprivateTA™. UprivateTA™为您的留学生涯保驾护航。