如果你也在 怎样代写多元统计分析Multivariate Statistical Analysis这个学科遇到相关的难题,请随时右上角联系我们的24/7代写客服。多元统计分析Multivariate Statistical Analysis在此重定向。在数学上的用法,见多变量微积分。多变量统计是统计学的一个分支,包括同时观察和分析一个以上的结果变量。多变量统计涉及到理解每一种不同形式的多变量分析的不同目的和背景,以及它们之间的关系。多变量统计在特定问题上的实际应用可能涉及几种类型的单变量和多变量分析,以了解变量之间的关系以及它们与所研究问题的相关性。

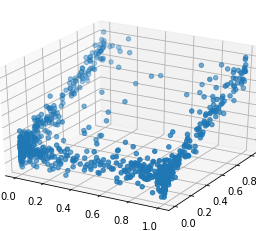

多元统计分析Multivariate Statistical Analysis通常情况下,希望使用多变量分析的研究会因为问题的维度而停滞。这些问题通常通过使用代理模型来缓解,代理模型是基于物理学的代码的高度精确的近似。由于代用模型采取方程的形式,它们可以被快速评估。这成为大规模MVA研究的一个有利因素:在基于物理学的代码中,整个设计空间的蒙特卡洛模拟是困难的,而在评估代用模型时,它变得微不足道,代用模型通常采取响应面方程的形式。

my-assignmentexpert™ 多元统计分析Multivariate Statistical Analysis作业代写,免费提交作业要求, 满意后付款,成绩80\%以下全额退款,安全省心无顾虑。专业硕 博写手团队,所有订单可靠准时,保证 100% 原创。my-assignmentexpert™, 最高质量的多元统计分析Multivariate Statistical Analysis作业代写,服务覆盖北美、欧洲、澳洲等 国家。 在代写价格方面,考虑到同学们的经济条件,在保障代写质量的前提下,我们为客户提供最合理的价格。 由于统计Statistics作业种类很多,同时其中的大部分作业在字数上都没有具体要求,因此多元统计分析Multivariate Statistical Analysis作业代写的价格不固定。通常在经济学专家查看完作业要求之后会给出报价。作业难度和截止日期对价格也有很大的影响。

想知道您作业确定的价格吗? 免费下单以相关学科的专家能了解具体的要求之后在1-3个小时就提出价格。专家的 报价比上列的价格能便宜好几倍。

my-assignmentexpert™ 为您的留学生涯保驾护航 在数学Mathematics作业代写方面已经树立了自己的口碑, 保证靠谱, 高质且原创的多元统计分析Multivariate Statistical Analysis代写服务。我们的专家在数学Mathematics代写方面经验极为丰富,各种多元统计分析Multivariate Statistical Analysis相关的作业也就用不着 说。

我们提供的多元统计分析Multivariate Statistical Analysis及其相关学科的代写,服务范围广, 其中包括但不限于:

非线性方法 nonlinear method functional analysis

变分法 Calculus of Variations

统计代写|多元统计分析作业代写Multivariate Statistical Analysis代考|The Likelihood Function

Suppose that $\left{x_{i}\right}_{i=1}^{n}$ is an i.i.d. sample from a population with pdf $f(x ; \theta)$. The aim is to estimate $\theta \in \mathbb{R}^{k}$ which is a vector of unknown parameters. The likelihood function is defined as the joint density $L(\mathcal{X} ; \theta)$ of the observations $x_{i}$ considered as a function of $\theta$ :

$$

L(\mathcal{X} ; \theta)=\prod_{i=1}^{n} f\left(x_{i} ; \theta\right)

$$

where $\mathcal{X}$ denotes the sample of the data matrix with the observations $x_{1}^{\top}, \ldots, x_{n}^{\top}$ in each row. The maximum likelihood estimator (MLE) of $\theta$ is defined as

$$

\widehat{\theta}=\arg \max {\theta} L(\mathcal{X} ; \theta) . $$ Often it is easier to maximize the log-likelihood function $$ \ell(\mathcal{X} ; \theta)=\log L(\mathcal{X} ; \theta), $$ which is equivalent since the logarithm is a monotone one-to-one function. Hence $$ \widehat{\theta}=\arg \max {\theta} L(\mathcal{X} ; \theta)=\arg \max _{\theta} \ell(\mathcal{X} ; \theta) .

$$

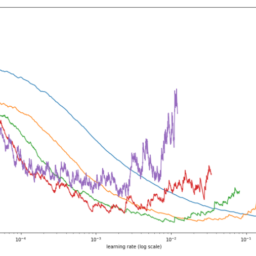

The following examples illustrate cases where the maximization process can be performed analytically, i.e., we will obtain an explicit analytical expression for $\widehat{\theta}$. Unfortunately, in other situations, the maximization process can be more intricate, involving nonlinear optimization techniques. In the latter case, given a sample $\mathcal{X}$ and the likelihood function, numerical methods will be used to determine the value of $\theta$ maximizing $L(\mathcal{X} ; \theta)$ or $\ell(\mathcal{X} ; \theta)$. These numerical methods are typically based on Newton-Raphson iterative techniques.

统计代写|多元统计分析作业代写Multivariate Statistical Analysis代考|The Cramer-Rao Lower Bound

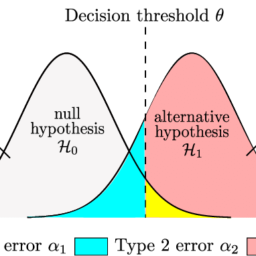

As pointed out above, an important question in estimation theory is whether an estimator $\widehat{\theta}$ has certain desired properties, in particular, if it converges to the unknown parameter $\theta$ it is supposed to estimate. One typical property we want for an estimator is unbiasedness, meaning that on the average, the estimator hits its target: $E(\widehat{\theta})=\theta$. We have seen for instance (see Example 6.2) that $\bar{x}$ is an unbiased estimator of $\mu$ and $\mathcal{S}$ is a biased estimator of $\Sigma$ in finite samples. If we restrict ourselves to unbiased estimation then the natural question is whether the estimator shares some optimality properties in terms of its sampling variance. Since we focus on unbiasedness, we look for an estimator with the smallest possible variance.

In this context, the Cramer-Rao lower bound will give the minimal achievable variance for any unbiased estimator. This result is valid under very general regularity conditions (discussed below). One of the most important applications of the Cramer-Rao lower bound is that it provides the asymptotic optimality property of maximum likelihood estimators. The Cramer-Rao theorem involves the score function and its properties which will be derived first.

The score function $s(\mathcal{X} ; \theta)$ is the derivative of the $\log$ likelihood function w.r.t. $\theta \in \mathbb{R}^{k}$

$$

s(\mathcal{X} ; \theta)=\frac{\partial}{\partial \theta} \ell(\mathcal{X} ; \theta)=\frac{1}{L(\mathcal{X} ; \theta)} \frac{\partial}{\partial \theta} L(\mathcal{X} ; \theta) .

$$

The covariance matrix $\mathcal{F}_{n}=\operatorname{Var}{s(\mathcal{X} ; \theta)}$ is called the Fisher information matrix. In what follows, we will give some interesting properties of score functions.

多元统计分析代写

统计代写|多元统计分析作业代写MULTIVARIATE STATISTICAL ANALYSIS代考|THE LIKELIHOOD FUNCTION

假设\left{x_{i}\right}_{i=1}^{n}\left{x_{i}\right}_{i=1}^{n}是来自具有 pdf 的总体的 iid 样本F(X;θ). 目的是估计θ∈Rķ这是一个未知参数的向量。似然函数定义为联合密度大号(X;θ)的意见X一世被认为是一个函数θ :

大号(X;θ)=∏一世=1nF(X一世;θ)

在哪里X表示具有观测值的数据矩阵的样本X1⊤,…,Xn⊤在每一行。最大似然估计米大号和的θ定义为

$$

L(\mathcal{X} ; \theta)=\prod_{i=1}^{n} f\left(x_{i} ; \theta\right)

$$

where $\mathcal{X}$ denotes the sample of the data matrix with the observations $x_{1}^{\top}, \ldots, x_{n}^{\top}$ in each row. The maximum likelihood estimator (MLE) of $\theta$ is defined as

$$

\widehat{\theta}=\arg \max {\theta} L(\mathcal{X} ; \theta) . $$ Often it is easier to maximize the log-likelihood function $$ \ell(\mathcal{X} ; \theta)=\log L(\mathcal{X} ; \theta), $$ which is equivalent since the logarithm is a monotone one-to-one function. Hence $$ \widehat{\theta}=\arg \max {\theta} L(\mathcal{X} ; \theta)=\arg \max _{\theta} \ell(\mathcal{X} ; \theta) .

$$

下面的例子说明了最大化过程可以分析执行的情况,即,我们将获得一个明确的分析表达式θ^. 不幸的是,在其他情况下,最大化过程可能更加复杂,涉及非线性优化技术。在后一种情况下,给定一个样本X和似然函数,数值方法将用于确定θ最大化大号(X;θ)或者ℓ(X;θ). 这些数值方法通常基于 Newton-Raphson 迭代技术。

统计代写|多元统计分析作业代写MULTIVARIATE STATISTICAL ANALYSIS代考|THE CRAMER-RAO LOWER BOUND

如上所述,估计理论中的一个重要问题是估计量是否θ^具有某些所需的属性,特别是如果它收敛到未知参数θ它应该估计。我们希望估计器的一个典型属性是无偏性,这意味着平均而言,估计器达到了目标:和(θ^)=θ. 例如,我们已经看到s和和和X一种米pl和6.2那X¯是一个无偏估计量μ和小号是一个有偏估计量Σ在有限样本中。如果我们将自己限制在无偏估计,那么自然的问题是估计量是否在其抽样方差方面具有一些最优性。由于我们关注的是无偏性,因此我们寻找具有最小可能方差的估计量。

在这种情况下,Cramer-Rao 下限将给出任何无偏估计量的最小可实现方差。这个结果在非常一般的正则条件下是有效的d一世sC在ss和db和l这在. Cramer-Rao 下界最重要的应用之一是它提供了最大似然估计量的渐近最优性。Cramer-Rao 定理涉及将首先导出的得分函数及其性质。

评分函数s(X;θ)是的导数日志似然函数θ∈Rķ

s(X;θ)=∂∂θℓ(X;θ)=1大号(X;θ)∂∂θ大号(X;θ).

协方差矩阵Fn=曾是s(X;θ)称为 Fisher 信息矩阵。在下文中,我们将给出分数函数的一些有趣属性。

统计代写|多元统计分析作业代写Multivariate Statistical Analysis代考 请认准UprivateTA™. UprivateTA™为您的留学生涯保驾护航。