如果你也在 怎样代写凸优化Convex optimization 这个学科遇到相关的难题,请随时右上角联系我们的24/7代写客服。凸优化Convex optimization由于在大规模资源分配、信号处理和机器学习等领域的广泛应用,人们对凸优化的兴趣越来越浓厚。本书旨在解决凸优化问题的算法的最新和可访问的发展。

凸优化Convex optimization无约束可以很容易地用梯度下降(最陡下降的特殊情况)或牛顿方法解决,结合线搜索适当的步长;这些可以在数学上证明收敛速度很快,尤其是后一种方法。[22]如果目标函数是二次函数,也可以使用KKT矩阵技术求解具有线性等式约束的凸优化(它推广到牛顿方法的一种变化,即使初始化点不满足约束也有效),但通常也可以通过线性代数消除等式约束或解决对偶问题来解决。

凸优化Convex optimization代写,免费提交作业要求, 满意后付款,成绩80\%以下全额退款,安全省心无顾虑。专业硕 博写手团队,所有订单可靠准时,保证 100% 原创。 最高质量的凸优化Convex optimization作业代写,服务覆盖北美、欧洲、澳洲等 国家。 在代写价格方面,考虑到同学们的经济条件,在保障代写质量的前提下,我们为客户提供最合理的价格。 由于作业种类很多,同时其中的大部分作业在字数上都没有具体要求,因此凸优化Convex optimization作业代写的价格不固定。通常在专家查看完作业要求之后会给出报价。作业难度和截止日期对价格也有很大的影响。

同学们在留学期间,都对各式各样的作业考试很是头疼,如果你无从下手,不如考虑my-assignmentexpert™!

my-assignmentexpert™提供最专业的一站式服务:Essay代写,Dissertation代写,Assignment代写,Paper代写,Proposal代写,Proposal代写,Literature Review代写,Online Course,Exam代考等等。my-assignmentexpert™专注为留学生提供Essay代写服务,拥有各个专业的博硕教师团队帮您代写,免费修改及辅导,保证成果完成的效率和质量。同时有多家检测平台帐号,包括Turnitin高级账户,检测论文不会留痕,写好后检测修改,放心可靠,经得起任何考验!

想知道您作业确定的价格吗? 免费下单以相关学科的专家能了解具体的要求之后在1-3个小时就提出价格。专家的 报价比上列的价格能便宜好几倍。

我们在数学Mathematics代写方面已经树立了自己的口碑, 保证靠谱, 高质且原创的数学Mathematics代写服务。我们的专家在凸优化Convex optimization代写方面经验极为丰富,各种凸优化Convex optimization相关的作业也就用不着 说。

数学代写|凸优化代写Convex Optimization代考|Incremental Methods – Computational Exercise

This exercise deals with the (perhaps approximate) solution of a system of linear inequalities $c_i^{\prime} x \leq b_i, i=1, \ldots, m$, where $c_i \in \Re^n$ and $b_i \in \Re$ are given.

(a) Consider a variation of the Kaczmarz algorithm that operates in cycles as follows. At the end of cycle $k$, we set $x_{k+1}=\psi_{m, k}$, where $\psi_{m, k}$ is obtained after the $m$ steps

$$

\psi_{i, k}=\psi_{i-1, k}-\frac{\alpha_k}{\left|c_i\right|^2} \max \left{0, c_i^{\prime} \psi_{i-1, k}-b_i\right} c_i, \quad i=1, \ldots, m,

$$

starting with $\psi_{0, k}=x_k$. Show that the algorithm can be viewed as an incremental gradient method for a suitable differentiable cost function.

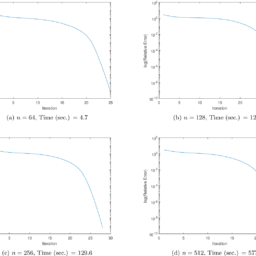

(b) Implement the algorithm of (a) for two examples where $n=2$ and $m=100$. In the first example, the vectors $c_i$ have the form $c_i=\left(\xi_i, \zeta_i\right)$, where $\xi_i, \zeta_i$, as well as $b_i$, are chosen randomly and independently from $[-100,100]$ according to a uniform distribution. In the second example, the vectors $c_i$ have the form $c_i=\left(\xi_i, \zeta_i\right)$, where $\xi_i, \zeta_i$ are chosen randomly and independently within $[-10,10]$ according to a uniform distribution, while $b_i$ is chosen randomly and independently within $[0,1000]$ according to a uniform distribution. Experiment with different starting points and stepsize choices, and deterministic and randomized orders of selection of the indexes $i$ for iteration. Explain your experimental results in terms of the theoretical behavior described in Section 2.1.

数学代写|凸优化代写Convex Optimization代考|Convergence of the Incremental Gradient Method

Consider the minimization of a cost function

$$

f(x)=\sum_{i=1}^m f_i(x)

$$

where $f_i: \Re^n \mapsto \Re$ are continuously differentiable, and let $\left{x_k\right}$ be a sequence generated by the incremental gradient method. Assume that for some constants $L, C, D$, and all $i=1, \ldots, m$, we have

$$

\left|\nabla f_i(x)-\nabla f_i(y)\right| \leq L|x-y|, \quad \forall x, y \in \Re^n,

$$

and

$$

\left|\nabla f_i(x)\right| \leq C+D|\nabla f(x)|, \quad \forall x \in \Re^n .

$$

Assume also that

$$

\sum_{k=0}^{\infty} \alpha_k=\infty, \quad \sum_{k=0}^{\infty} \alpha_k^2<\infty .

$$

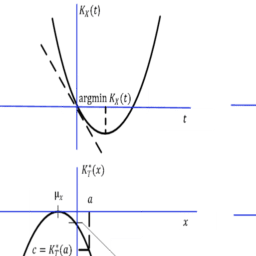

Show that either $f\left(x_k\right) \rightarrow-\infty$ or else $f\left(x_k\right)$ converges to a finite value and $\lim {k \rightarrow \infty} \nabla f\left(x_k\right)=0$. Furthermore, every limit point $\bar{x}$ of $\left{x_k\right}$ satisfies $\nabla f(\bar{x})=0$. Abbreviated Solution: The idea is to view the incremental gradient method as a gradient method with errors, so that the result of Exercise 2.6 can be used. For simplicity we assume that $m=2$. The proof is similar when $m>2$. We have $$ \psi_1=x_k-\alpha_k \nabla f_1\left(x_k\right), \quad x{k+1}=\psi_1-\alpha_k \nabla f_2\left(\psi_1\right)

$$

凸优化代写

数学代写|凸优化代写Convex Optimization代考|Incremental Methods – Computational Exercise

这个练习处理线性不等式$c_i^{\prime} x \leq b_i, i=1, \ldots, m$系统的(可能近似的)解,其中给出了$c_i \in \Re^n$和$b_i \in \Re$。

(a)考虑Kaczmarz算法的一种变体,其循环如下。在循环$k$结束时,我们设置$x_{k+1}=\psi_{m, k}$,其中$\psi_{m, k}$是在$m$步骤之后获得的

$$

\psi_{i, k}=\psi_{i-1, k}-\frac{\alpha_k}{\left|c_i\right|^2} \max \left{0, c_i^{\prime} \psi_{i-1, k}-b_i\right} c_i, \quad i=1, \ldots, m,

$$

从$\psi_{0, k}=x_k$开始。表明该算法可以看作是一种适合于可微代价函数的增量梯度法。

(b)对$n=2$和$m=100$两个示例实现(a)算法。在第一个示例中,向量$c_i$的形式为$c_i=\left(\xi_i, \zeta_i\right)$,其中$\xi_i, \zeta_i$和$b_i$是根据均匀分布随机选择的,独立于$[-100,100]$。在第二个示例中,向量$c_i$的形式为$c_i=\left(\xi_i, \zeta_i\right)$,其中$\xi_i, \zeta_i$是根据均匀分布在$[-10,10]$内随机独立选择的,而$b_i$是根据均匀分布在$[0,1000]$内随机独立选择的。实验采用不同的起始点和步长选择,以及确定和随机的索引选择顺序$i$进行迭代。用2.1节中描述的理论行为来解释你的实验结果。

数学代写|凸优化代写Convex Optimization代考|Convergence of the Incremental Gradient Method

考虑成本函数的最小化

$$

f(x)=\sum_{i=1}^m f_i(x)

$$

其中$f_i: \Re^n \mapsto \Re$是连续可微的,设$\left{x_k\right}$为增量梯度法生成的序列。假设对于一些常数$L, C, D$和所有的$i=1, \ldots, m$,我们有

$$

\left|\nabla f_i(x)-\nabla f_i(y)\right| \leq L|x-y|, \quad \forall x, y \in \Re^n,

$$

和

$$

\left|\nabla f_i(x)\right| \leq C+D|\nabla f(x)|, \quad \forall x \in \Re^n .

$$

同时假设

$$

\sum_{k=0}^{\infty} \alpha_k=\infty, \quad \sum_{k=0}^{\infty} \alpha_k^2<\infty . $$ 证明$f\left(x_k\right) \rightarrow-\infty$或$f\left(x_k\right)$收敛于有限值和$\lim {k \rightarrow \infty} \nabla f\left(x_k\right)=0$。进而,$\left{x_k\right}$的每一个极限点$\bar{x}$都满足$\nabla f(\bar{x})=0$。简化解决方案:其思想是将增量梯度方法视为带有错误的梯度方法,以便可以使用练习2.6的结果。为简单起见,我们假设$m=2$。证明是类似的$m>2$。我们有 $$ \psi_1=x_k-\alpha_k \nabla f_1\left(x_k\right), \quad x{k+1}=\psi_1-\alpha_k \nabla f_2\left(\psi_1\right)

$$

数学代写|凸优化代写Convex Optimization代考 请认准UprivateTA™. UprivateTA™为您的留学生涯保驾护航。