如果你也在 怎样代写信息论information theory 这个学科遇到相关的难题,请随时右上角联系我们的24/7代写客服。信息论information theory的一个关键衡量标准是熵。熵量化了随机变量的值或随机过程的结果中所涉及的不确定性的数量。例如,确定一个公平的抛硬币的结果(有两个同样可能的结果)比确定一个掷骰子的结果(有六个同样可能的结果)提供的信息要少(熵值较低)。

信息论information theory基本课题的应用包括源编码/数据压缩(如ZIP文件),以及信道编码/错误检测和纠正(如DSL)。它的影响对于旅行者号深空任务的成功、光盘的发明、移动电话的可行性和互联网的发展都至关重要。该理论在其他领域也有应用,包括统计推理、密码学、神经生物学、感知、语言学、分子代码的进化和功能(生物信息学)、热物理、分子动力学、量子计算、黑洞、信息检索、情报收集、剽窃检测、模式识别、异常检测甚至艺术创作。

my-assignmentexpert™信息论information theory代写,免费提交作业要求, 满意后付款,成绩80\%以下全额退款,安全省心无顾虑。专业硕 博写手团队,所有订单可靠准时,保证 100% 原创。my-assignmentexpert, 最高质量的信息论information theory作业代写,服务覆盖北美、欧洲、澳洲等 国家。 在代写价格方面,考虑到同学们的经济条件,在保障代写质量的前提下,我们为客户提供最合理的价格。 由于统计Statistics作业种类很多,同时其中的大部分作业在字数上都没有具体要求,因此信息论information theory作业代写的价格不固定。通常在经济学专家查看完作业要求之后会给出报价。作业难度和截止日期对价格也有很大的影响。

想知道您作业确定的价格吗? 免费下单以相关学科的专家能了解具体的要求之后在1-3个小时就提出价格。专家的 报价比上列的价格能便宜好几倍。

my-assignmentexpert™ 为您的留学生涯保驾护航 在澳洲代写方面已经树立了自己的口碑, 保证靠谱, 高质且原创的澳洲代写服务。我们的专家在信息论information theory代写方面经验极为丰富,各种信息论information theory相关的作业也就用不着 说。

我们提供的信息论information theory及其相关学科的代写,服务范围广, 其中包括但不限于:

数学代写|信息论代写Information Theory代考|The Shannon Information Bit

A fundamental contribution of Shannon is the notion of a bit as a measure of information. Typically, when we think of a bit, we think of a two-valued quantity that can be in the state “off” or the state “on.” We represent this bit with a binary number that can be “0” or “1.” We also associate a physical representation with a bit-this physical representation can be whether a light switch is off or on, whether a transistor allows current to flow or not, whether a large number of magnetic spins point in one direction or another, the list going on and on. These are all physical notions of a bit.

Shannon’s notion of a bit is quite different from these physical notions, and we motivate his notion with the example of a fair coin. Without flipping the coin, we have no idea what the result of a coin flip will be – our best guess at the result is to guess randomly. If someone else learns the result of a random coin flip, we can ask this person the question: What was the result? We then learn one bit of information.

Though it may seem obvious, it is important to stress that we do not learn any (or not as much) information if we do not ask the right question. This point becomes even more important in the quantum case. Suppose that the coin is not fair – without loss of generality, suppose the probability of “heads” is greater than the probability of “tails.” In this case, we would not be as surprised to learn that the result of a coin flip is “heads.” We may say in this case that we would learn less than one bit of information if we were to ask someone the result of the coin flip.

The Shannon binary entropy is a measure of information. Given a probability distribution $(p, 1-p)$ for a binary random variable, its Shannon binary entropy is

$$

h_2(p) \equiv-p \log p-(1-p) \log (1-p)

$$

where (here and throughout the book, unless stated explicitly otherwise) the logarithm is taken base two. The Shannon binary entropy measures information in units of bits. We will discuss it in more detail in the next chapter and in Chapter 10 .

The Shannon bit, or Shannon binary entropy, is a measure of the surprise upon learning the outcome of a random binary experiment. Thus, the Shannon bit has a completely different interpretation from that of the physical bit. The outcome of the coin flip resides in a physical bit, but it is the information associated with the random nature of the physical bit that we would like to measure. It is this notion of a bit that is important in information theory.

数学代写|信息论代写Information Theory代考|A Measure of Quantum Information

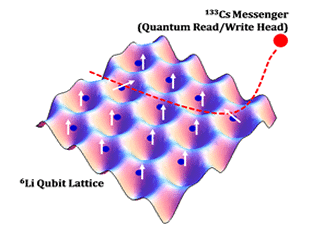

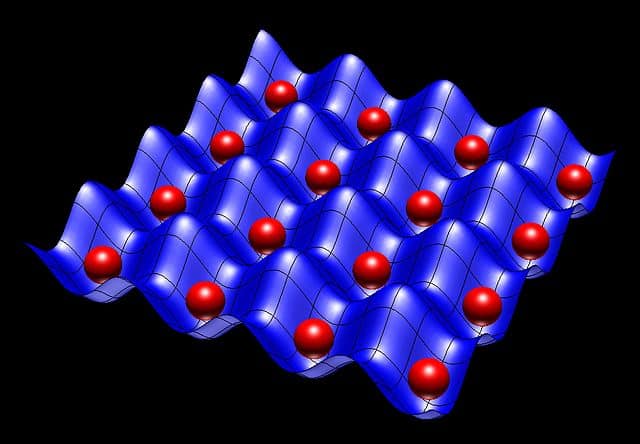

The above section discusses Shannon’s notion of a bit as a measure of information. A natural question is whether there is an analogous measure of quantum information, but before we can even ask that question, we might first wonder: What is quantum information? As in the classical case, there is a physical notion of quantum information. A quantum state always resides “in” a physical system. Perhaps another way of stating this idea is that every physical system is in some quantum state. The physical notion of a quantum bit, or qubit for short (pronounced “cue – bit”), is a two-level quantum system. Examples of two-level quantum systems are the spin of the electron, the polarization of a photon, or an atom with a ground state and an excited state. The physical notion of a qubit is straightforward to understand once we have a grasp of the quantum theory.

A more pressing question for us in this book is to understand an informational notion of a qubit, as in the Shannon sense. In the classical case, we quantify information by the amount of knowledge we gain after learning the answer to a probabilistic question. In the quantum world, what knowledge can we have of a quantum state?

Sometimes we may know the exact quantum state of a physical system because we prepared the quantum system in a certain way. For example, we may prepare an electron in its “spin-up in the $z$ direction” state, where $\left|\uparrow_z\right\rangle$ denotes this state. If we prepare the state in this way, we know for certain that the state is indeed $\left|\uparrow_z\right\rangle$ and no other state. Thus, we do not gain any information, or equivalently, there is no removal of uncertainty if someone else tells us that the state is $\left|\uparrow_z\right\rangle$. We may say that this state has zero qubits of quantum information, where the term “qubit” now refers to a measure of the quantum information of a state.

In the quantum world, we also have the option of measuring this state in the $x$ direction. The postulates of quantum theory, given in Chapter 3 , predict that the state will then be $\left|\uparrow_x\right\rangle$ or $\left|\downarrow_x\right\rangle$ with equal probability after measuring in the

$x$ direction. One interpretation of this aspect of quantum theory is that the system does not have any definite state in the $x$ direction: in fact there is maximal uncertainty about its $x$ direction, if we know that the physical system has a definite $z$ direction. This behavior is one manifestation of the Heisenberg uncertainty principle. So before performing the measurement, we have no knowledge of the resulting state and we gain one Shannon bit of information after learning the result of the measurement. If we use Shannon’s notion of entropy and perform an $x$ measurement, this classical measure loses some of its capability here to capture our knowledge of the state of the system. It is inadequate to capture our knowledge of the state because we actually prepared it ourselves and know with certainty that it is in the state $\left|\uparrow_z\right\rangle$. With these different notions of information gain, which one is the most appropriate for the quantum case?

It turns out that the first way of thinking is the one that is most useful for quantifying quantum information. If someone tells us the definite quantum state of a particular physical system, and this state is indeed the true state, then we have complete knowledge of the state and thus do not learn more “qubits” of quantum information from this point onward. This line of thinking is perhaps similar in one sense to the classical world, but different from the classical world, in the sense of the case presented in the previous paragraph.

信息论代写

数学代写|信息论代写Information Theory代考|The Shannon Information Bit

香农的一个基本贡献是比特作为信息度量的概念。通常,当我们想到比特时,我们想到的是一个双值量,它可以处于“关”或“开”的状态。我们用一个二进制数表示这个位,可以是“0”或“1”。我们还将物理表征与比特联系起来——这种物理表征可以是灯开关是开还是关,晶体管是否允许电流流动,大量的磁自旋是指向一个方向还是另一个方向,等等。这些都是一点的物理概念。

香农的“位”概念与这些物理概念截然不同,我们以一枚均匀硬币为例来解释他的概念。如果不抛硬币,我们就不知道抛硬币的结果会是什么——我们对结果的最佳猜测是随机猜测。如果别人知道随机抛硬币的结果,我们可以问这个人这个问题:结果是什么?然后我们学习一点信息。

虽然这似乎是显而易见的,但重要的是要强调,如果我们没有提出正确的问题,我们就不会学到任何(或没有那么多)信息。这一点在量子的情况下变得更加重要。假设这枚硬币不是公平的——在不失一般性的前提下,假设出现正面的概率大于出现反面的概率。在这种情况下,当我们得知抛硬币的结果是“正面”时,我们不会感到惊讶。在这种情况下,我们可能会说,如果我们问某人抛硬币的结果,我们会得到不到一个比特的信息。

香农二值熵是一种信息度量。给定二进制随机变量的概率分布$(p, 1-p)$,其香农二进制熵为

$$

h_2(p) \equiv-p \log p-(1-p) \log (1-p)

$$

其中(此处和全书,除非另有明确说明)对数以2为底。香农二值熵以比特为单位测量信息。我们将在下一章和第10章中更详细地讨论它。

香农比特,或香农二进制熵,是对随机二进制实验结果的惊讶程度的度量。因此,香农钻头与物理钻头有着完全不同的解释。掷硬币的结果存在于物理位中,但我们想要测量的是与物理位的随机性相关的信息。在信息论中,比特的概念是很重要的。

数学代写|信息论代写Information Theory代考|A Measure of Quantum Information

上一节讨论了香农关于比特作为信息度量的概念。一个自然的问题是,是否有量子信息的类似测量,但在我们提出这个问题之前,我们可能首先想知道:什么是量子信息?在经典情况下,有量子信息的物理概念。量子态总是存在于物理系统中。也许另一种表述这个想法的方式是,每个物理系统都处于某种量子态。量子比特或简称qubit(发音为“cue – bit”)的物理概念是一个两级量子系统。双能级量子系统的例子是电子的自旋,光子的极化,或者具有基态和激发态的原子。一旦我们掌握了量子理论,量子比特的物理概念就很容易理解了。

在这本书中,对我们来说更紧迫的问题是理解量子比特的信息概念,就像香农所说的那样。在经典的情况下,我们通过学习概率问题的答案后获得的知识量来量化信息。在量子世界里,我们对量子态有什么了解?

有时我们可能知道一个物理系统的确切量子态,因为我们以某种方式准备了量子系统。例如,我们可以制备一个电子“在z方向向上自旋”的状态,其中$\left|\ upparrow_z \right\rangle$表示这个状态。如果我们以这种方式准备状态,我们肯定知道状态确实是$\left|\uparrow_z\right\rangle$,而不是其他状态。因此,我们没有获得任何信息,或者等价地说,如果其他人告诉我们状态是$\left|\ upparrow_z \right\rangle$,则不确定性没有消除。我们可以说这个状态有零量子比特的量子信息,这里的术语“量子比特”现在指的是一个状态的量子信息的度量。

在量子世界中,我们也可以选择在x方向上测量这个状态。第3章给出的量子理论假设预测,在测量后,状态将以等概率为$\left|\uparrow_x\right\rangle$或$\left|\downarrow_x\right\rangle$

美元$ x方向。对量子理论这方面的一种解释是,系统在x方向上没有任何确定的状态:事实上,如果我们知道物理系统有一个确定的z方向,那么它的x方向就存在最大的不确定性。这种行为是海森堡测不准原理的一种表现。因此,在执行测量之前,我们不知道结果状态,并且在了解测量结果后获得1香农比特的信息。如果我们使用香农的熵的概念并执行一个x测量,这个经典的测量在这里失去了一些捕捉我们对系统状态的知识的能力。捕捉我们对状态的知识是不够的,因为我们实际上自己准备了它,并且确信它处于状态$\left|\ upparrow_z \right\rangle$。有了这些不同的信息增益概念,哪一个最适合量子情况呢?

事实证明,第一种思维方式对于量化量子信息是最有用的。如果有人告诉我们一个特定物理系统的确定量子状态,并且这个状态确实是真实的状态,那么我们对这个状态有了完全的了解,因此从这一点开始,我们不需要学习更多的量子信息。这种思路也许在某种意义上与古典世界相似,但在上一段所呈现的情况下,与古典世界不同。

数学代写|信息论代写Information Theory代考 请认准UprivateTA™. UprivateTA™为您的留学生涯保驾护航。

微观经济学代写

微观经济学是主流经济学的一个分支,研究个人和企业在做出有关稀缺资源分配的决策时的行为以及这些个人和企业之间的相互作用。my-assignmentexpert™ 为您的留学生涯保驾护航 在数学Mathematics作业代写方面已经树立了自己的口碑, 保证靠谱, 高质且原创的数学Mathematics代写服务。我们的专家在图论代写Graph Theory代写方面经验极为丰富,各种图论代写Graph Theory相关的作业也就用不着 说。

线性代数代写

线性代数是数学的一个分支,涉及线性方程,如:线性图,如:以及它们在向量空间和通过矩阵的表示。线性代数是几乎所有数学领域的核心。

博弈论代写

现代博弈论始于约翰-冯-诺伊曼(John von Neumann)提出的两人零和博弈中的混合策略均衡的观点及其证明。冯-诺依曼的原始证明使用了关于连续映射到紧凑凸集的布劳威尔定点定理,这成为博弈论和数学经济学的标准方法。在他的论文之后,1944年,他与奥斯卡-莫根斯特恩(Oskar Morgenstern)共同撰写了《游戏和经济行为理论》一书,该书考虑了几个参与者的合作游戏。这本书的第二版提供了预期效用的公理理论,使数理统计学家和经济学家能够处理不确定性下的决策。

微积分代写

微积分,最初被称为无穷小微积分或 “无穷小的微积分”,是对连续变化的数学研究,就像几何学是对形状的研究,而代数是对算术运算的概括研究一样。

它有两个主要分支,微分和积分;微分涉及瞬时变化率和曲线的斜率,而积分涉及数量的累积,以及曲线下或曲线之间的面积。这两个分支通过微积分的基本定理相互联系,它们利用了无限序列和无限级数收敛到一个明确定义的极限的基本概念 。

计量经济学代写

什么是计量经济学?

计量经济学是统计学和数学模型的定量应用,使用数据来发展理论或测试经济学中的现有假设,并根据历史数据预测未来趋势。它对现实世界的数据进行统计试验,然后将结果与被测试的理论进行比较和对比。

根据你是对测试现有理论感兴趣,还是对利用现有数据在这些观察的基础上提出新的假设感兴趣,计量经济学可以细分为两大类:理论和应用。那些经常从事这种实践的人通常被称为计量经济学家。

Matlab代写

MATLAB 是一种用于技术计算的高性能语言。它将计算、可视化和编程集成在一个易于使用的环境中,其中问题和解决方案以熟悉的数学符号表示。典型用途包括:数学和计算算法开发建模、仿真和原型制作数据分析、探索和可视化科学和工程图形应用程序开发,包括图形用户界面构建MATLAB 是一个交互式系统,其基本数据元素是一个不需要维度的数组。这使您可以解决许多技术计算问题,尤其是那些具有矩阵和向量公式的问题,而只需用 C 或 Fortran 等标量非交互式语言编写程序所需的时间的一小部分。MATLAB 名称代表矩阵实验室。MATLAB 最初的编写目的是提供对由 LINPACK 和 EISPACK 项目开发的矩阵软件的轻松访问,这两个项目共同代表了矩阵计算软件的最新技术。MATLAB 经过多年的发展,得到了许多用户的投入。在大学环境中,它是数学、工程和科学入门和高级课程的标准教学工具。在工业领域,MATLAB 是高效研究、开发和分析的首选工具。MATLAB 具有一系列称为工具箱的特定于应用程序的解决方案。对于大多数 MATLAB 用户来说非常重要,工具箱允许您学习和应用专业技术。工具箱是 MATLAB 函数(M 文件)的综合集合,可扩展 MATLAB 环境以解决特定类别的问题。可用工具箱的领域包括信号处理、控制系统、神经网络、模糊逻辑、小波、仿真等。