如果你也在 怎样代写回归分析Regression Analysis 这个学科遇到相关的难题,请随时右上角联系我们的24/7代写客服。回归分析Regression Analysis被广泛用于预测和预报,其使用与机器学习领域有很大的重叠。在某些情况下,回归分析可以用来推断自变量和因变量之间的因果关系。重要的是,回归本身只揭示了固定数据集中因变量和自变量集合之间的关系。为了分别使用回归进行预测或推断因果关系,研究者必须仔细论证为什么现有的关系对新的环境具有预测能力,或者为什么两个变量之间的关系具有因果解释。当研究者希望使用观察数据来估计因果关系时,后者尤其重要。

回归分析Regression Analysis在统计建模中,回归分析是一组统计过程,用于估计因变量(通常称为 “结果 “或 “响应 “变量,或机器学习术语中的 “标签”)与一个或多个自变量(通常称为 “预测因子”、”协变量”、”解释变量 “或 “特征”)之间的关系。回归分析最常见的形式是线性回归,即根据特定的数学标准找到最适合数据的直线(或更复杂的线性组合)。例如,普通最小二乘法计算唯一的直线(或超平面),使真实数据与该直线(或超平面)之间的平方差之和最小。由于特定的数学原因(见线性回归),这使得研究者能够在自变量具有一组给定值时估计因变量的条件期望值(或人口平均值)。不太常见的回归形式使用稍微不同的程序来估计替代位置参数(例如,量化回归或必要条件分析),或在更广泛的非线性模型集合中估计条件期望值(例如,非参数回归)。

回归分析Regression Analysis代写,免费提交作业要求, 满意后付款,成绩80\%以下全额退款,安全省心无顾虑。专业硕 博写手团队,所有订单可靠准时,保证 100% 原创。 最高质量的回归分析Regression Analysis作业代写,服务覆盖北美、欧洲、澳洲等 国家。 在代写价格方面,考虑到同学们的经济条件,在保障代写质量的前提下,我们为客户提供最合理的价格。 由于作业种类很多,同时其中的大部分作业在字数上都没有具体要求,因此回归分析Regression Analysis作业代写的价格不固定。通常在专家查看完作业要求之后会给出报价。作业难度和截止日期对价格也有很大的影响。

同学们在留学期间,都对各式各样的作业考试很是头疼,如果你无从下手,不如考虑my-assignmentexpert™!

my-assignmentexpert™提供最专业的一站式服务:Essay代写,Dissertation代写,Assignment代写,Paper代写,Proposal代写,Proposal代写,Literature Review代写,Online Course,Exam代考等等。my-assignmentexpert™专注为留学生提供Essay代写服务,拥有各个专业的博硕教师团队帮您代写,免费修改及辅导,保证成果完成的效率和质量。同时有多家检测平台帐号,包括Turnitin高级账户,检测论文不会留痕,写好后检测修改,放心可靠,经得起任何考验!

想知道您作业确定的价格吗? 免费下单以相关学科的专家能了解具体的要求之后在1-3个小时就提出价格。专家的 报价比上列的价格能便宜好几倍。

我们在统计Statistics代写方面已经树立了自己的口碑, 保证靠谱, 高质且原创的统计Statistics代写服务。我们的专家在回归分析Regression Analysis代写方面经验极为丰富,各种回归分析Regression Analysis相关的作业也就用不着 说。

统计代写|回归分析代写Regression Analysis代考|Transformation of the $X$ Data Only

If you transform $X$ to $f(X)$, then your new model is

$$

Y=\beta_0+\beta_1 f(X)+\varepsilon

$$

having mean function

$$

\mathrm{E}(Y \mid X=x)=\beta_0+\beta_1 f(x)

$$

Your goal is therefore to choose an $f(x)$ function that gives a good model for the conditional mean function, $\mathrm{E}(Y \mid X=x)$. Recall that LOESS curves are estimates of the conditional mean function $\mathrm{E}(Y \mid X=x)$; therefore, if you transform $X$, you want $\beta_0+\beta_1 f(x)$ to look somewhat like the LOESS curve, for some values of the parameters $\beta_0$ and $\beta_1$.

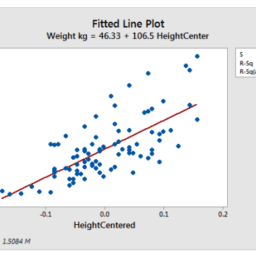

Consider the log-transform $f(x)=\ln (x)$. Figure 5.1 shows different graphs of $\beta_0+\beta_1 \ln (x)$, as a function of $x$, for different $\beta_0$ and $\beta_1$.

In Figure 5.1, note the following:

The graphs are meant to model $\mathrm{E}(Y \mid X=x$ ), in their original (not transformed) units of measurement. So if a LOESS smooth over the $\left(x_i, y_i\right)$ scatterplot (again, in the original, not transformed units) looks something like what you see in Figure 5.1, then the $\ln (x)$ transformation might be suitable.

The graphs all have $x>0$. This brings up an important point: You cannot logtransform data that are 0 or negative.

As $x \rightarrow 0$, the function tends to either $+\infty$ or $-\infty$. This behavior may or may not be desirable, from a subject matter standpoint, and is something you should consider when deciding whether to use the $\log (X)$ transformation. If your data have zeros or values close to zero, consider using the transformation $\ln (x+1)$ rather than $\ln (x)$.

Notice that the parameters $\beta_0$ and $\beta_1$ in the transformed model have different meanings than they do in the untransformed model: In the transformed model, the parameter $\beta_0$ is the place where the function intercepts the $x=1$ axis (the red line), rather than the $x=0$ axis. Also, the parameter $\beta_1$ is no longer the slope, but rather a multiplier of $\ln (x)$. But you still can say that $\beta_1>0$ corresponds to an increasing function and $\beta_1<0$ corresponds to a decreasing function.

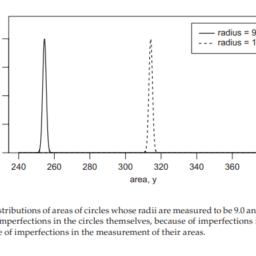

Now consider the inverse transform $f(x)=x^{-1}$. Figure 5.2 shows different graphs of $\mathrm{E}(Y \mid X=x)=\beta_0+\beta_1 x^{-1}$, as a function of $x$, for different $\beta_0$ and $\beta_1$.

统计代写|回归分析代写Regression Analysis代考|What Should I Use with My Data, In $(x)$, or Inverse of $X$, or No Transform at All?

The maximized log likelihood is a great statistic for comparing models. Higher log likelihood implies a better fit of the model to the data. Recall from Chapter 2 that the $\log$ likelihood for the classical model is

$$

L L(\theta \mid \text { data })=-\frac{n}{2} \ln (2 \pi)-\frac{n}{2} \ln \left(\sigma^2\right)-\frac{1}{2 \sigma^2} \sum_{i=1}^n\left{y_i-\left(\beta_0+\beta_1 x_i\right)\right}^2

$$

Plugging in the MLEs $\hat{\beta}0, \hat{\beta}_1$, and $\hat{\sigma}^2=\frac{1}{n} \sum{i=1}^n\left{y_i-\left(\hat{\beta}0+\hat{\beta}_1 x_i\right)\right}^2$, you get the maximized log likelihood $-\frac{n}{2} \ln (2 \pi)-\frac{n}{2} \ln \left(\hat{\sigma}^2\right)-\frac{1}{2 \hat{\sigma}^2} \sum{i=1}^n\left{y_i-\left(\hat{\beta}_0+\hat{\beta}_1 x_i\right)\right}^2$. Simplifying this expression gives you the maximized $\log$ likelihood.

The maximized log likelihood in the classical regression model

$$

L L=-\frac{n}{2} \ln (2 \pi)-\frac{n}{2} \ln \left(\hat{\sigma}^2\right)-\frac{n}{2}

$$

Notice that larger maximized log likelihood corresponds directly to smaller $\hat{\sigma}^2$, which is intuitively logical: Models with a smaller sum of squared deviations from the fitted mean function to the data, fit the data better.

With the $X$ variable expressed as either $X, X^{-1}$, or $\ln (X)$, you will get three different maximized $\log$ likelihoods. The largest of these $\log$ likelihoods will correspond to the model giving the minimum sum of squared deviations from the fitted function (i.e., the minimum $\hat{\sigma}^2$ ). You can get the maximized log likelihood statistic from R using the “logLik(fit)” command, where ” $\mathrm{fit}$ ” is the fitted lm object.

回归分析代写

统计代写|回归分析代写Regression Analysis代考|Transformation of the $X$ Data Only

如果您将$X$转换为$f(X)$,那么您的新模型是

$$

Y=\beta_0+\beta_1 f(X)+\varepsilon

$$

具有平均函数

$$

\mathrm{E}(Y \mid X=x)=\beta_0+\beta_1 f(x)

$$

因此,您的目标是选择一个$f(x)$函数,该函数为条件平均函数$\mathrm{E}(Y \mid X=x)$提供良好的模型。回想一下,黄土曲线是条件均值函数$\mathrm{E}(Y \mid X=x)$的估计;因此,如果对$X$进行变换,您希望$\beta_0+\beta_1 f(x)$对于参数$\beta_0$和$\beta_1$的某些值看起来有点像黄土曲线。

考虑对$f(x)=\ln (x)$进行对数变换。图5.1显示了$\beta_0+\beta_1 \ln (x)$的不同图形,作为$x$的函数,对于不同的$\beta_0$和$\beta_1$ .

在图5.1中,请注意以下内容:

这些图形旨在以其原始(未转换的)度量单位对$\mathrm{E}(Y \mid X=x$)进行建模。因此,如果在$\left(x_i, y_i\right)$散点图(同样,在原始单元中,未转换的单元中)上的黄土平滑看起来像您在图5.1中看到的那样,那么$\ln (x)$转换可能是合适的。

图中都有$x>0$。这引出了一个重要的问题:不能对0或负数的数据进行日志转换。

如$x \rightarrow 0$,函数趋向于$+\infty$或$-\infty$。从主题的角度来看,这种行为可能是可取的,也可能不是可取的,在决定是否使用$\log (X)$转换时应该考虑这种行为。如果数据为零或值接近于零,请考虑使用转换$\ln (x+1)$而不是$\ln (x)$ .

请注意,转换模型中的参数$\beta_0$和$\beta_1$与未转换模型中的含义不同:在转换模型中,参数$\beta_0$是函数与$x=1$轴(红线)相交的位置,而不是$x=0$轴相交的位置。此外,参数$\beta_1$不再是斜率,而是$\ln (x)$的乘数。但是你仍然可以说$\beta_1>0$对应一个递增函数$\beta_1<0$对应一个递减函数。

现在考虑逆变换$f(x)=x^{-1}$。图5.2给出了不同$\beta_0$和$\beta_1$下$\mathrm{E}(Y \mid X=x)=\beta_0+\beta_1 x^{-1}$作为$x$函数的不同曲线图。

统计代写|回归分析代写Regression Analysis代考|What Should I Use with My Data, In $(x)$, or Inverse of $X$, or No Transform at All?

最大对数似然是比较模型的一个很好的统计量。较高的对数似然意味着模型与数据的拟合更好。回想一下第2章,经典模型的$\log$似然是

$$

L L(\theta \mid \text { data })=-\frac{n}{2} \ln (2 \pi)-\frac{n}{2} \ln \left(\sigma^2\right)-\frac{1}{2 \sigma^2} \sum_{i=1}^n\left{y_i-\left(\beta_0+\beta_1 x_i\right)\right}^2

$$

插入MLEs $\hat{\beta}0, \hat{\beta}_1$和$\hat{\sigma}^2=\frac{1}{n} \sum{i=1}^n\left{y_i-\left(\hat{\beta}0+\hat{\beta}_1 x_i\right)\right}^2$,您得到最大的对数似然$-\frac{n}{2} \ln (2 \pi)-\frac{n}{2} \ln \left(\hat{\sigma}^2\right)-\frac{1}{2 \hat{\sigma}^2} \sum{i=1}^n\left{y_i-\left(\hat{\beta}_0+\hat{\beta}_1 x_i\right)\right}^2$。简化这个表达式可以得到最大的$\log$可能性。

经典回归模型中的最大对数似然

$$

L L=-\frac{n}{2} \ln (2 \pi)-\frac{n}{2} \ln \left(\hat{\sigma}^2\right)-\frac{n}{2}

$$

注意,较大的最大对数似然直接对应较小的$\hat{\sigma}^2$,这是直观的逻辑:从拟合的均值函数到数据的平方偏差和较小的模型,可以更好地拟合数据。

将$X$变量表示为$X, X^{-1}$或$\ln (X)$,您将得到三种不同的最大化$\log$可能性。这些$\log$似然中的最大值将对应于给出与拟合函数的最小平方偏差和的模型(即最小$\hat{\sigma}^2$)。您可以使用“logLik(fit)”命令从R中获得最大的日志似然统计量,其中“$\mathrm{fit}$”是拟合的lm对象。

统计代写|回归分析代写Regression Analysis代考 请认准UprivateTA™. UprivateTA™为您的留学生涯保驾护航。

微观经济学代写

微观经济学是主流经济学的一个分支,研究个人和企业在做出有关稀缺资源分配的决策时的行为以及这些个人和企业之间的相互作用。my-assignmentexpert™ 为您的留学生涯保驾护航 在数学Mathematics作业代写方面已经树立了自己的口碑, 保证靠谱, 高质且原创的数学Mathematics代写服务。我们的专家在图论代写Graph Theory代写方面经验极为丰富,各种图论代写Graph Theory相关的作业也就用不着 说。

线性代数代写

线性代数是数学的一个分支,涉及线性方程,如:线性图,如:以及它们在向量空间和通过矩阵的表示。线性代数是几乎所有数学领域的核心。

博弈论代写

现代博弈论始于约翰-冯-诺伊曼(John von Neumann)提出的两人零和博弈中的混合策略均衡的观点及其证明。冯-诺依曼的原始证明使用了关于连续映射到紧凑凸集的布劳威尔定点定理,这成为博弈论和数学经济学的标准方法。在他的论文之后,1944年,他与奥斯卡-莫根斯特恩(Oskar Morgenstern)共同撰写了《游戏和经济行为理论》一书,该书考虑了几个参与者的合作游戏。这本书的第二版提供了预期效用的公理理论,使数理统计学家和经济学家能够处理不确定性下的决策。

微积分代写

微积分,最初被称为无穷小微积分或 “无穷小的微积分”,是对连续变化的数学研究,就像几何学是对形状的研究,而代数是对算术运算的概括研究一样。

它有两个主要分支,微分和积分;微分涉及瞬时变化率和曲线的斜率,而积分涉及数量的累积,以及曲线下或曲线之间的面积。这两个分支通过微积分的基本定理相互联系,它们利用了无限序列和无限级数收敛到一个明确定义的极限的基本概念 。

计量经济学代写

什么是计量经济学?

计量经济学是统计学和数学模型的定量应用,使用数据来发展理论或测试经济学中的现有假设,并根据历史数据预测未来趋势。它对现实世界的数据进行统计试验,然后将结果与被测试的理论进行比较和对比。

根据你是对测试现有理论感兴趣,还是对利用现有数据在这些观察的基础上提出新的假设感兴趣,计量经济学可以细分为两大类:理论和应用。那些经常从事这种实践的人通常被称为计量经济学家。

Matlab代写

MATLAB 是一种用于技术计算的高性能语言。它将计算、可视化和编程集成在一个易于使用的环境中,其中问题和解决方案以熟悉的数学符号表示。典型用途包括:数学和计算算法开发建模、仿真和原型制作数据分析、探索和可视化科学和工程图形应用程序开发,包括图形用户界面构建MATLAB 是一个交互式系统,其基本数据元素是一个不需要维度的数组。这使您可以解决许多技术计算问题,尤其是那些具有矩阵和向量公式的问题,而只需用 C 或 Fortran 等标量非交互式语言编写程序所需的时间的一小部分。MATLAB 名称代表矩阵实验室。MATLAB 最初的编写目的是提供对由 LINPACK 和 EISPACK 项目开发的矩阵软件的轻松访问,这两个项目共同代表了矩阵计算软件的最新技术。MATLAB 经过多年的发展,得到了许多用户的投入。在大学环境中,它是数学、工程和科学入门和高级课程的标准教学工具。在工业领域,MATLAB 是高效研究、开发和分析的首选工具。MATLAB 具有一系列称为工具箱的特定于应用程序的解决方案。对于大多数 MATLAB 用户来说非常重要,工具箱允许您学习和应用专业技术。工具箱是 MATLAB 函数(M 文件)的综合集合,可扩展 MATLAB 环境以解决特定类别的问题。可用工具箱的领域包括信号处理、控制系统、神经网络、模糊逻辑、小波、仿真等。